FAQ

Tag : 4K

Rys historyczny

Rys historyczny

Obawy związane ze zbyt małymi elementami ekranowymi mają swoje przyczyny w głębokiej przeszłości. W odległych mrokach dziejów, pierwsi ludzi jaskiniowi projektowali swoje malunki naskalne na pierwszych komputerach z wczesnymi wersjami systemu Windows. Twórca systemu Windows, znany z wygłaszania wielu kwantyfikatorów absolutnych, jak choćby - "Komputery nigdy nie będą potrzebowały więcej jak 640kB pamięci", podobną filozofię zastosował rownież w przypadku graficznego interfejsu użytkownika. Nakazał projektantom, aby przyjęli założenie, że literka ma być narysowana ze stałej "x razy y" siatki pikseli i koniec. Kaplica, schluss! Nie przyszło chłopu do głowy, że ilość pikseli na monitorze może się zmienić. W wyniku takiej polityki, jeśli monitor był większy, przy tej samej rozdzielczości co mniejszy, wyświetlał większe litery i ikony. I oczywiście odwrotnie.

Z biegiem czasu jak topniały lodowce, technika komputerowa wykształciła więcej rozmiarów ekranów niż osławione kineskopowe Daewoo 14". Stopniowo też zwiększała się rozdzielczość, a w związku z tym, pojawił się aspekt większych lub mniejszych liter i ikonek. Szybko przekształciło się to w atawistyczne lęki, hamujące użytkowników przed wszystkim co nowsze. No bo nowsze = większa rozdzielczość = małe literki! Diabli nadali te HD, FullHD, WQHD a już UHD i 4K to zło wcielone. Na wzmiankę o 8K mdleli ci o słabszym sercu.

Czasy współczesne

Steve Jobs, nieodżałowany, nieżyjący już lider firmy Apple, kiedyś powiedział, że Microsoft zawsze zrzynał z systemów z jabłkiem. Można na ten temat dyskutować, ale żebyście zaraz nie zaczęli w siebie rzucać, nomen omen, monitorami, zawęźmy to stwierdzenie do ekranów graficznych. Otóż, facet miał rację. Jak tylko pojawiły się pierwsze OS-y od Apple, miały bardzo ładną typografię, która w Microsofcie zagościła dopiero dziesięciolecia później. W OS9, OSX, macOS nigdy nie było żadnych tam kwadratowych literek niezależnie od rozdzielczości. Kluczem było rysowanie wektorowe, wymyślone w Mezozoiku, gdzieś w okolicach Kredy, ale dlaczegoś, kompletnie olane przez Microsoft.

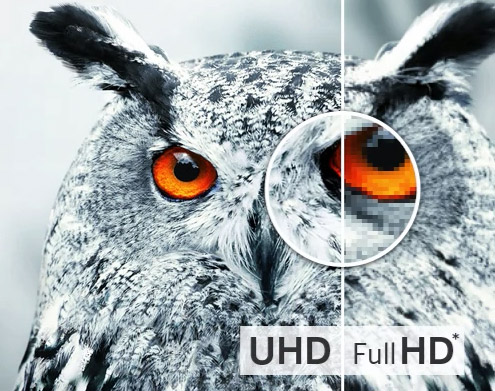

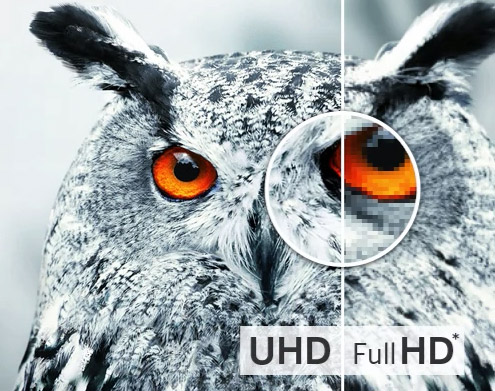

Do tej pory GUI rysowany grafiką pikselową był sztucznym ograniczeniem, uprzykrzającym życie wielu pokoleniom. Elementy rysowane wektorowo można sobie wyobrazić jako narysowanie kółka na kartce w kratkę. Rysujemy cyrklem kółko o średnicy np 10cm. Kółko jest gładkie, normalne. Teraz je kwantyzujemy, czyli zamazujemy te kratki przez które przechodzi okrąg. Jak się łatwo domyśleć, na szkolnej kartce w kratkę będzie bardziej "kwadratowe" niż na kratce z bloku milimetrowego. A jeśli zastosujemy kartkę w kratkę o tak dużym zagęszczeniu, że kratki trzeba oglądać przez lupę, kółko będzie idealne. I tu jest pies pogrzebany! Mając montor o dużo gęstszej siatce pikseli mamy takiej samej średnicy kółko, ale bardziej gładkie niż na moniotrze z mniejszą gęstością pikseli. Proste? No kurde, proste, ale ile pokoleń dinozaurów musiało wymrzeć, aby powszechnie wprowadzić tak banalne rozwiązanie. Teraz każdy ma smartfona i się nawet nie zastanawia nad jego rozdzielczością. Wszystko wyświetla się tak naturalnie, że w ogóle tego nie zauważamy.

No dobra, ale czy mój komputer tak potrafi?

Potrafi, o ile nie siedzimy uparcie na Windows 3.1. Ok, trochę przesadziłem. Wszystkie systemy rysują interfejs normalnie, czyli wektorowo, nawet Windows, ale całkowicie poprawnie dopiero od wersji 10, konkretnie kompilacji 1709, czyli takiej sprzed kilku lat. Można śmiało kupować monitory UHD, 4K, 6K, 8K. Im bardziej "gęsty", tym lepiej!

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Nie, wszystko wyświetla się prawidłowo, o ile jest to wersja Windows 10, kompilacja 1709 lub nowsza. Biorąc pod uwagę, że wydanie 1709 zostało opublikowane w 2017r, można przyjąć, że każdy współczesny system wyświetla niezależnie od rozdzielczości, nie zaburzając wyglądu interfejsu.

Nie, wszystko wyświetla się prawidłowo, o ile jest to wersja Windows 10, kompilacja 1709 lub nowsza. Biorąc pod uwagę, że wydanie 1709 zostało opublikowane w 2017r, można przyjąć, że każdy współczesny system wyświetla niezależnie od rozdzielczości, nie zaburzając wyglądu interfejsu.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Standaryzacja

T erminy 4K i UHD oznaczają konkretne parametry obrazu, jednakże warto wiedzieć, że istnieje ich kilka odmian. 4K jest skrótowcem od 4 - kilo, czyli 4 tysiące, (oczywiście pikseli) w poziomie. W filmie, bowiem standard ten, jak i większość innych, ma swoje pochodzenie z techniki filmowej, dzieli się na kilka podstandardów: Full Aperture 4K, Academy 4K, Digital cinema 4K DCI, o mocno różnych ilościach pikseli i proporcjach obrazu.

erminy 4K i UHD oznaczają konkretne parametry obrazu, jednakże warto wiedzieć, że istnieje ich kilka odmian. 4K jest skrótowcem od 4 - kilo, czyli 4 tysiące, (oczywiście pikseli) w poziomie. W filmie, bowiem standard ten, jak i większość innych, ma swoje pochodzenie z techniki filmowej, dzieli się na kilka podstandardów: Full Aperture 4K, Academy 4K, Digital cinema 4K DCI, o mocno różnych ilościach pikseli i proporcjach obrazu.

Technika komputerowa

Na potrzeby monitorów zaimplementowano dwa ze standardów 4K, mianowicie telewizyjny 4K2K, zwany też potocznie UHD, 4K UHD albo po prostu 4K, oraz rzadziej standard filmowy - Digital cinema 4K DCI.

- 4K2K - 3840x2160

- 4K DCI - 4096x2160

4K a massmedia

Jak wiadomo, marketing non stop szuka czegoś, czym da się oczarować przyszłego nabywcę. W ten niegdyś sposób "powstało" FHD zamiast FullHD, choć to jeszcze można zrozumieć w przeciwieństwie do przeraźliwych, w ogóle nie istniejących tworów jak "1440p" zamiast poprawnego 2560x1440. Cel uświęca środki i stąd pojawiają się najrozmaitsze mniej lub bardziej mądre wypociny ludzi, którzy za wszelką cenę tworzą "nowość". W związku z 4K, tak po prawdzie to UHD, czyli najczęściej spotykana rozdzielczość 3840x2160. Jednak UHD zbyt kojarzy się ze starym, przaśnym, niemodnym FHD, więc uparcie na UHD mówi się "4K". Użycie czegoś nowszego, nieznanego do tej pory w przekazie reklamowym, ma nieść powiew świeżości.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość