Lepiej obrabiać zdjęcia jako AdobeRGB czy sRGB? A może DCI P3 lub ProPhoto?

Magia przestrzeni barwnych i gamutów

Kiedyś było jakoś lepiej

Stare powiedzenie, prawda? Szczególnie wśród nieco bardziej dojrzałej młodzieży. Monitory z czarno-białych stały się kolorowe i stało się cudownie. Nic więcej do szczęścia nie było potrzebne. No, może ekran o większej przekątnej. O jakości wyświetlanych kolorów zupełnie nikt nie myślał. Super, że w ogóle były.

Więcej = lepiej!

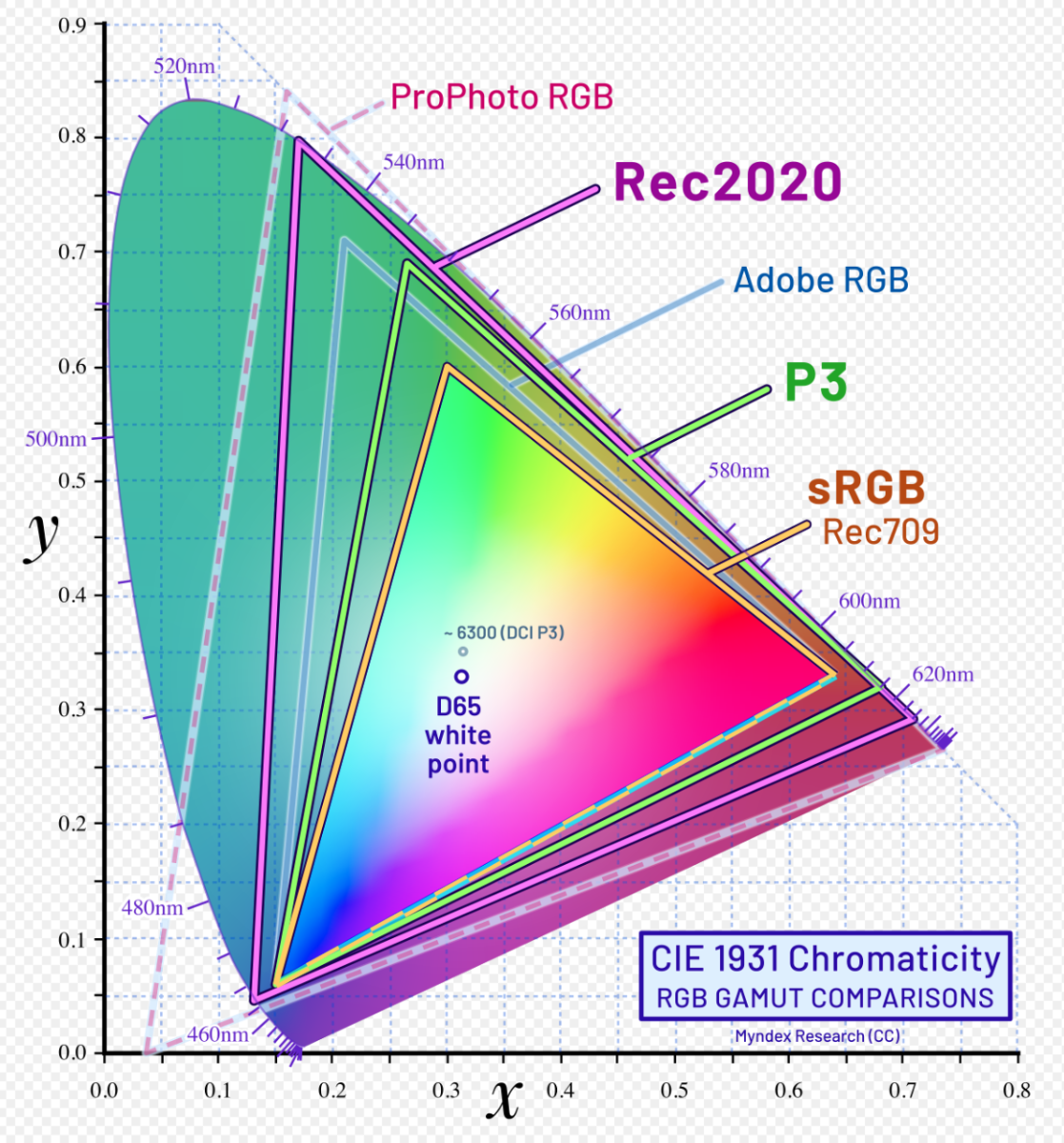

Tak się powszechnie uważa. No, chyba, że więcej rachunków za prąd, wówczas niekoniecznie. Ogólnie, w temacie koloru, kolorów, barw, zdaje się być oczywistym, że więcej odcieni, większy gamut oznacza wyższy poziom obróbki fotografii. Nawiasem mówiąc używane zamiennie terminy "przestrzeń" i "gamut" mają inne znaczenie. Kto o tym wiedział? Będzie na ten temat osobny mini-artykuł, poszukajcie w FAQ.

Więcej = lepiej?

Znak zapytania przy oczywistym stwierdzeniu? Nieprzypadkowo. Otóż jeśli weźmiemy pod uwagę takie terminy jak przestrzeń i kolory, to okazuje się, że za bardzo chcą iść w parze.

Więcej kolorów

Pisząc kolory, mam na myśli ilość kolorów w zdjęciu. Przestrzenie barwne zawierają konkretną ilość odcieni. Przestrzenie są podzielone (kwantyzowane) na odcienie co 1 dE. Coś jak metrówka podzielona na milimetry. To zgrubne wyjaśnienie, ale na potrzeby tego opracowania, wystarczy. Czyli, im większa przestrzeń, dłuższa metrówka, tym pomieści więcej odcieni. Przy czym, teoria mówiąca o wyświetlaniu 16,77 mln (zapis 256 odcieni na kanał, czyli zapis 8 bitowy) lub 1 mld kolorów (1024 odcieni na kanał, czyli zapis 10 bitowy) to w praktyce fikcja, bowiem docelowo w przestrzeni sRGB mieści się ok 800 tys odcieni a w AdobeRGB około 1,2 mln odcieni. Bardzo ważne: To są ilości odcieni możliwe do rozróżnienia przez człowieka. Tyle zatem rozróżnimy maksymalnie odcieni w zdjęciu. Więcej może być, ale i tak ich nie będzie widać.

Więcej przestrzeni

Internet twierdzi, że jeśli urządzenie wyświetlające nie wyświetla  ileśtam procentów (najczęściej 99% pokrycia) AdobeRGB, DCI-P3, sRGB, czy bogowie koloru wiedzą czego, to jest źle, dno, woodorosty i nic na takim ekranie nie widać. To nieprawda, a raczej marketingowe niedopowiedzenie, o czym traktuje ten artykuł: Czy monitor powinien miec pełny gamut kolorów, pokrycie 100% sRGB, AdobeRGB czy DCI P3?

ileśtam procentów (najczęściej 99% pokrycia) AdobeRGB, DCI-P3, sRGB, czy bogowie koloru wiedzą czego, to jest źle, dno, woodorosty i nic na takim ekranie nie widać. To nieprawda, a raczej marketingowe niedopowiedzenie, o czym traktuje ten artykuł: Czy monitor powinien miec pełny gamut kolorów, pokrycie 100% sRGB, AdobeRGB czy DCI P3?

Wszystkiego więcej, więc ile kolorów finalnie zawiera zdjęcie?

Teoria mówi, że miliony albo i miliardy. Wszak 255x255x255 to już dużo, a 1024x1024x1024 to dużo więcej niż dużo. Pamiętajcie, że monitory jak i programy graficzne mają palety jeszcze szersze, nawet 16 bitowe. Czyli ile to będzie 65535x65535x65535? To jest obróbka na palecie: 242141662159875 odcieni. Ponad 240 bilionów odciei! Fajnie, nie?

Rzeczywistość jest jednak "nieco" inna.

Przestrzenie i kolory w praktyce

Wywołanie z RAW-a

Jak wiecie, materiał zgrany z karty aparatu jako RAW, NEF, ARW, CR2 czy jak tam firmy nazywają, to nie jest zdjęcie. To zczytane dane z przetwornika, który po pierwsze nie bardzo jest RGB, oraz niespecjalnie rejestruje kolor, a tylko ilość światła jakie pada na poszczególne elementy fotoczułe, umieszczone za filtrami. Jest to więc materiał zawierający poziomy szarości w dziwacznych proporcjach, wcale nie po równo na kanały RGB.

Konieczne jest więc "wywołanie" RAW-a, czyli użycie oprogramowania, które "wie" jaka jest struktura danych w pliku RAW i przeliczy to na wartości kolorymetryczne każdego piksela zdjęcia. Mówiąc prościej, stworzy plik graficzny.

Gdzie moje miliony, czyli trudne decyzje życiowe fotografa

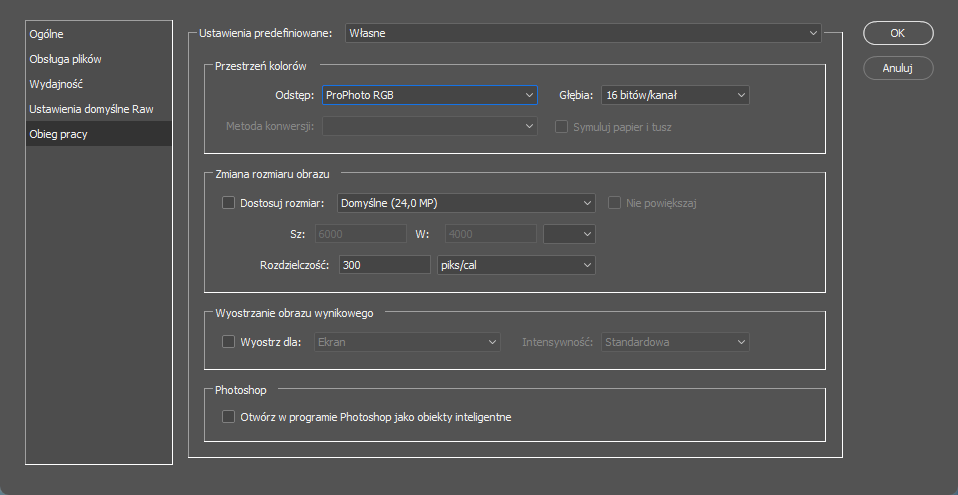

Podczas wywoływania RAW-ów, rzadko kiedy ingeruje się w ustawienia wywołania. A tymczasem na dole, przykład z popularnego Adobe Camera Raw, mamy takie maleńkie coś:

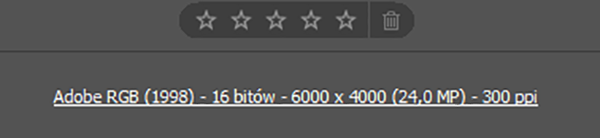

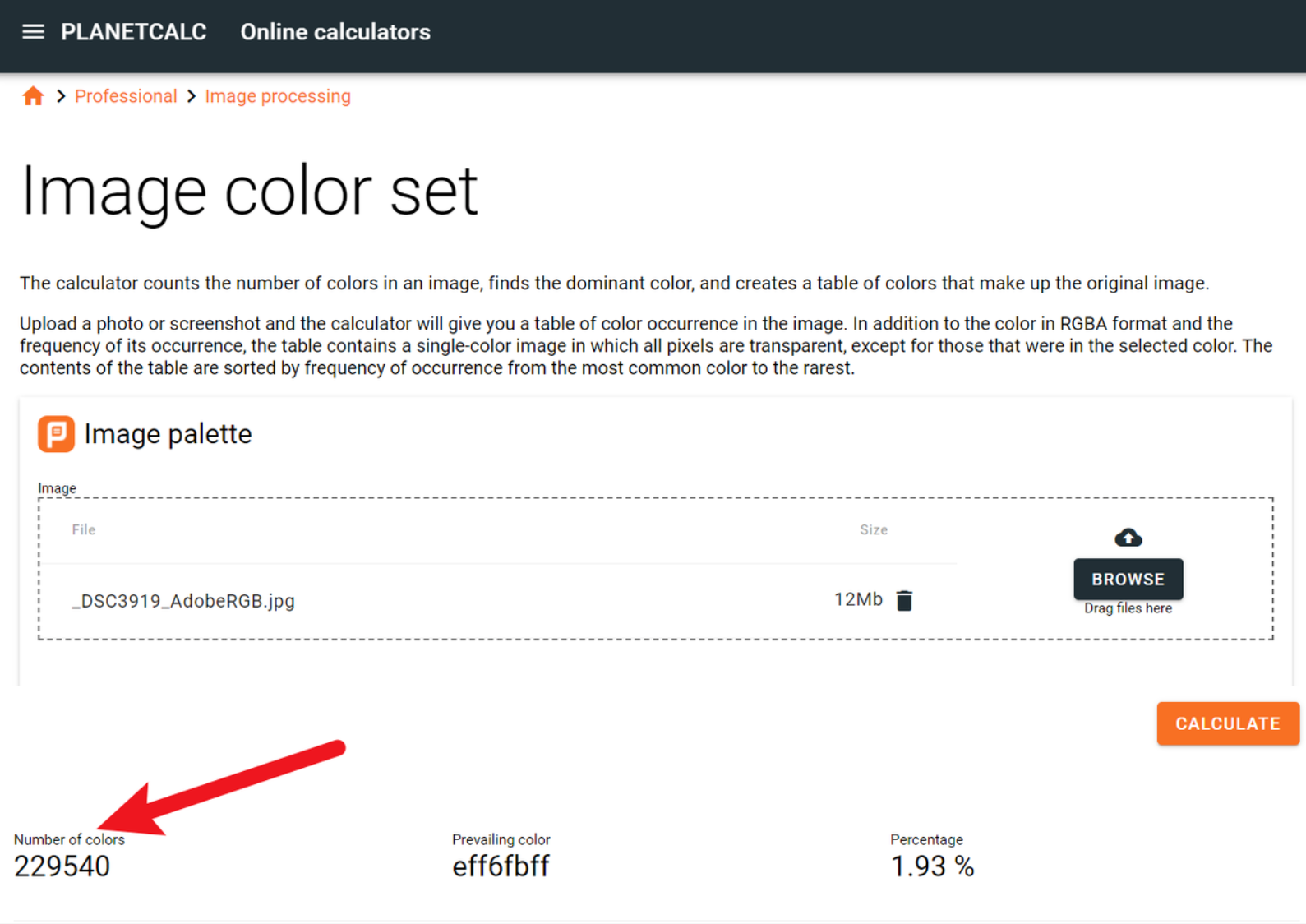

Stoi jak byk Adobe RGB i do takiej przestrzeni będzie renderowane gotowe zdjęcie. Wydaje się dobrze, szersza przestrzeń, więcej kolorów, zdjęcie będzie ze wszech miar lepsze. No, ale jedziemy dalej. Wywołumeny fotę, zapisujemy, oczywiście jako szerokogamutowe i w poczuciu dobrze spełnionego obowiązku idziemy na piw... eee... znaczy... herbatę. Dla porządku i poprawności metodologicznej wrzucam zdjęcie do analizatora. Jest tego dużo, zarówno jako samodzielne aplikacje jak i internetowe, nawet darmowe. No więc wkopiowuję fotkę i widzę: O żesz! Niecałe 300 tys odcieni? Jakiś żart? Gdzie moje miliony i miliardy kolorów? Wywołanie było z rozdzielczością 16 bitową, widać na poprzednim obrazku, czyli powinno być metrowa liczba odcieni, a nie ma! Co do groma? Spróbujmy może do aktualnie najnowszej mody DCI-P3.

O żesz! Niecałe 300 tys odcieni? Jakiś żart? Gdzie moje miliony i miliardy kolorów? Wywołanie było z rozdzielczością 16 bitową, widać na poprzednim obrazku, czyli powinno być metrowa liczba odcieni, a nie ma! Co do groma? Spróbujmy może do aktualnie najnowszej mody DCI-P3.

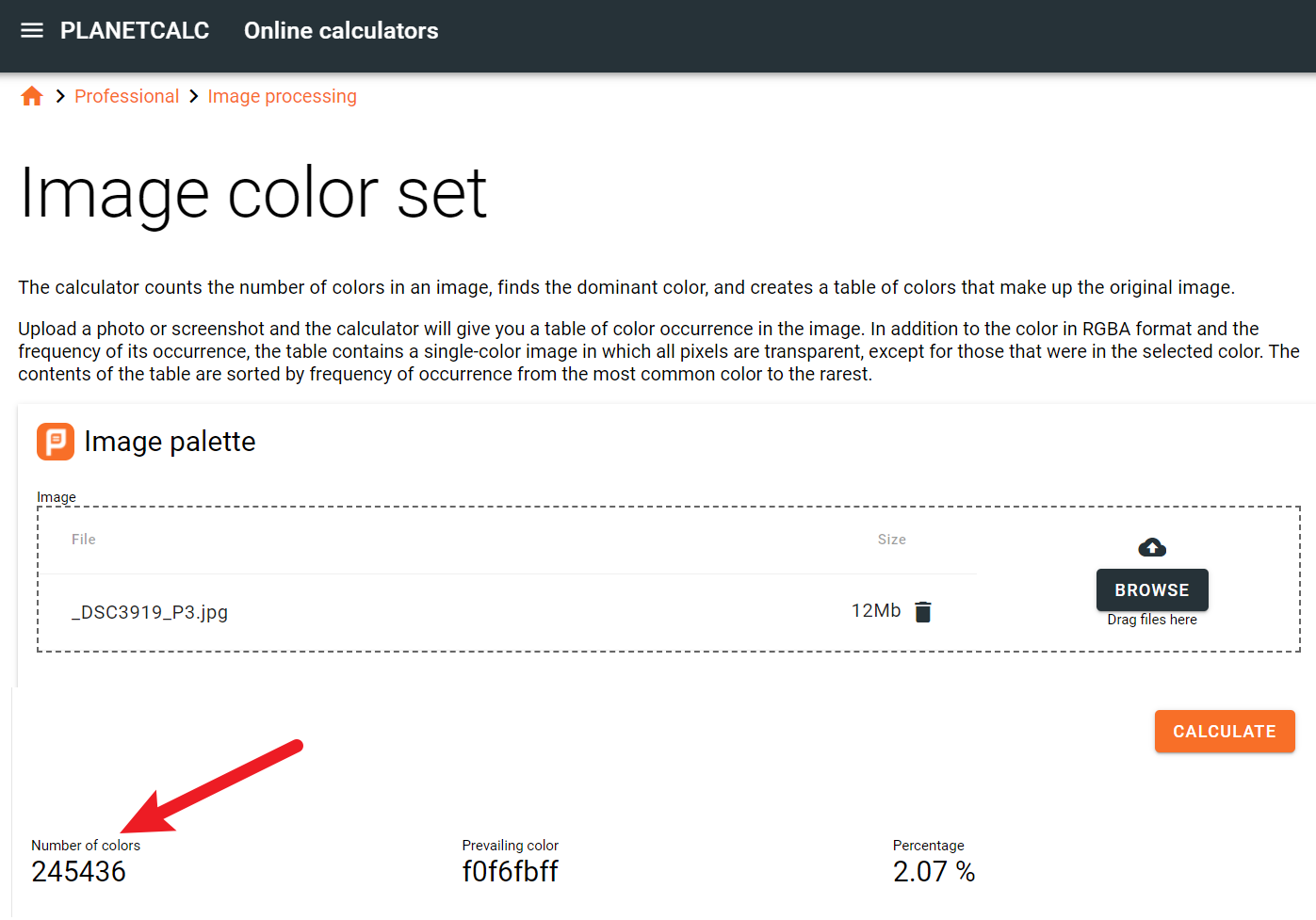

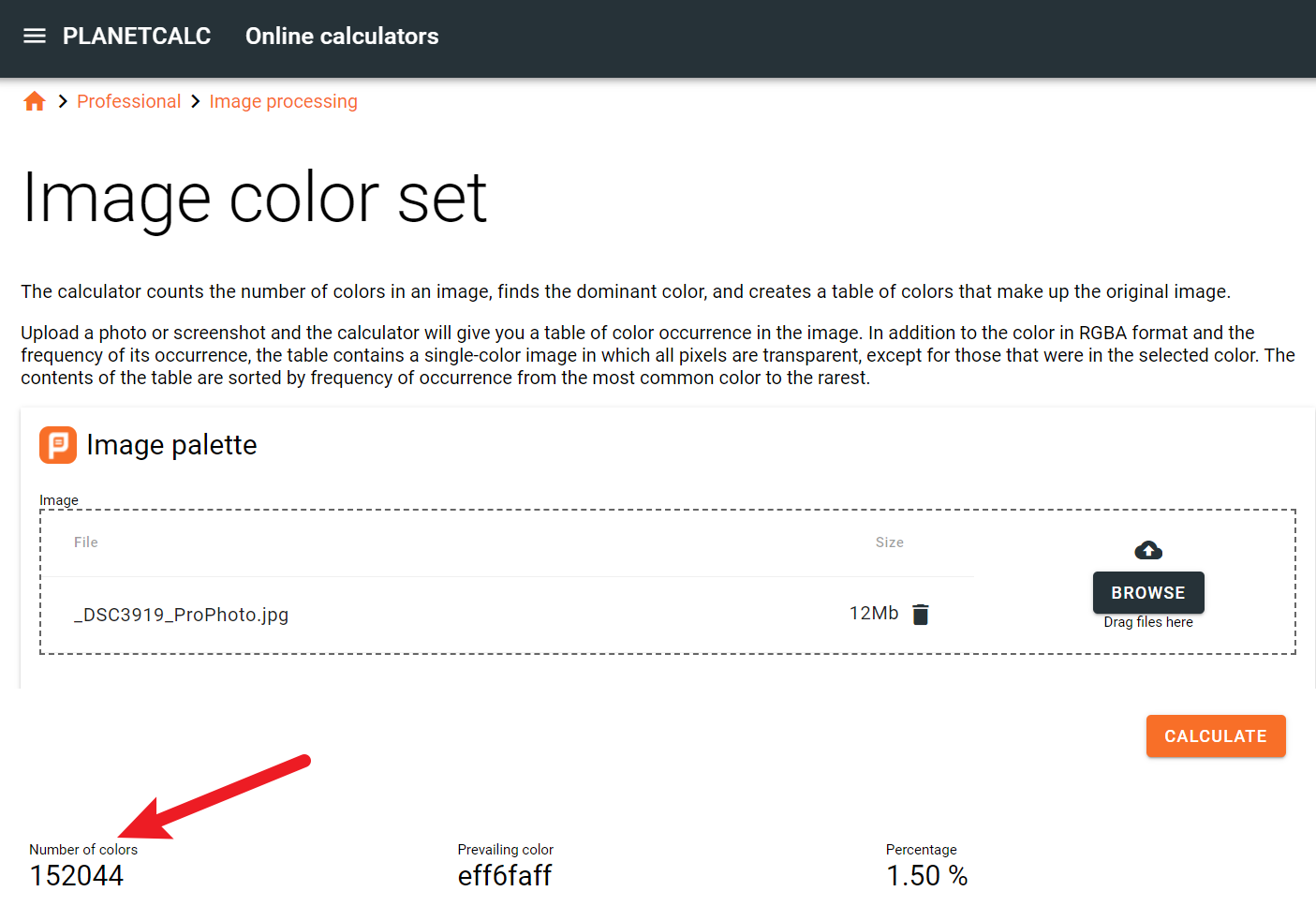

Jakby lepiej, ale i tak jest kosmiczna różnica między obietnicami we wszelkich poradnikach, artykułach, grupach dyskusyjnych i nawet na wszechwiedzącym Facebooku. Nie tak miało być! Światełko w głowie. Przecież w Lightroomie przestrzenią edycyjną jest Pro Photo. Największa, najlepsza i w ogóle super, debeściarska. Dajemy z grubej rury. Wywołuję do Pro photo!

Wrzucam plik do analizatora, sekundy wczytywania ciągną się w nieskończoność. Cała moja dotychczasowa kolorymetryczna rzeczywistość wisi na włosku nad odchłanią chaosu. Co prawda niby wszystko dąży do entropii, ale bez jaj. No i:

Rozumiecie coś tego?

Rozumiecie coś tego?

Prosta kolorymetria a wygląda jak bałagan

Dlaczego w zdjęciu jest tak mało odcieni?

Sprawa jest trywialna. Otóż zdjęcie to nie jest wzornik ze wszystkimi możliwymi kombinacjami 256 odcieni czerwonego, razy 256 odcieni zielonego, razy 256 odcieni niebieskiego. Nie mówiąc o zapisie 10 bitowym, czyli 1024 na każdy z kanałów. Fotografie różnych rzeczy będą zawierały różną ilość odcieni. Przykładowo, zdjęcie idealnie równej białej ściany będzie zawierało (w przybliżeniu) jeden odcień. Bogaty wizualnie pejzaż będzie zawierał sporo więcej. Nawiasem mówiąc użyte w tym teście zdjęcie to właśnie panorama górska.

Dlaczego im szersza przestrzeń, tym mniej kolorów w zdjęciu?

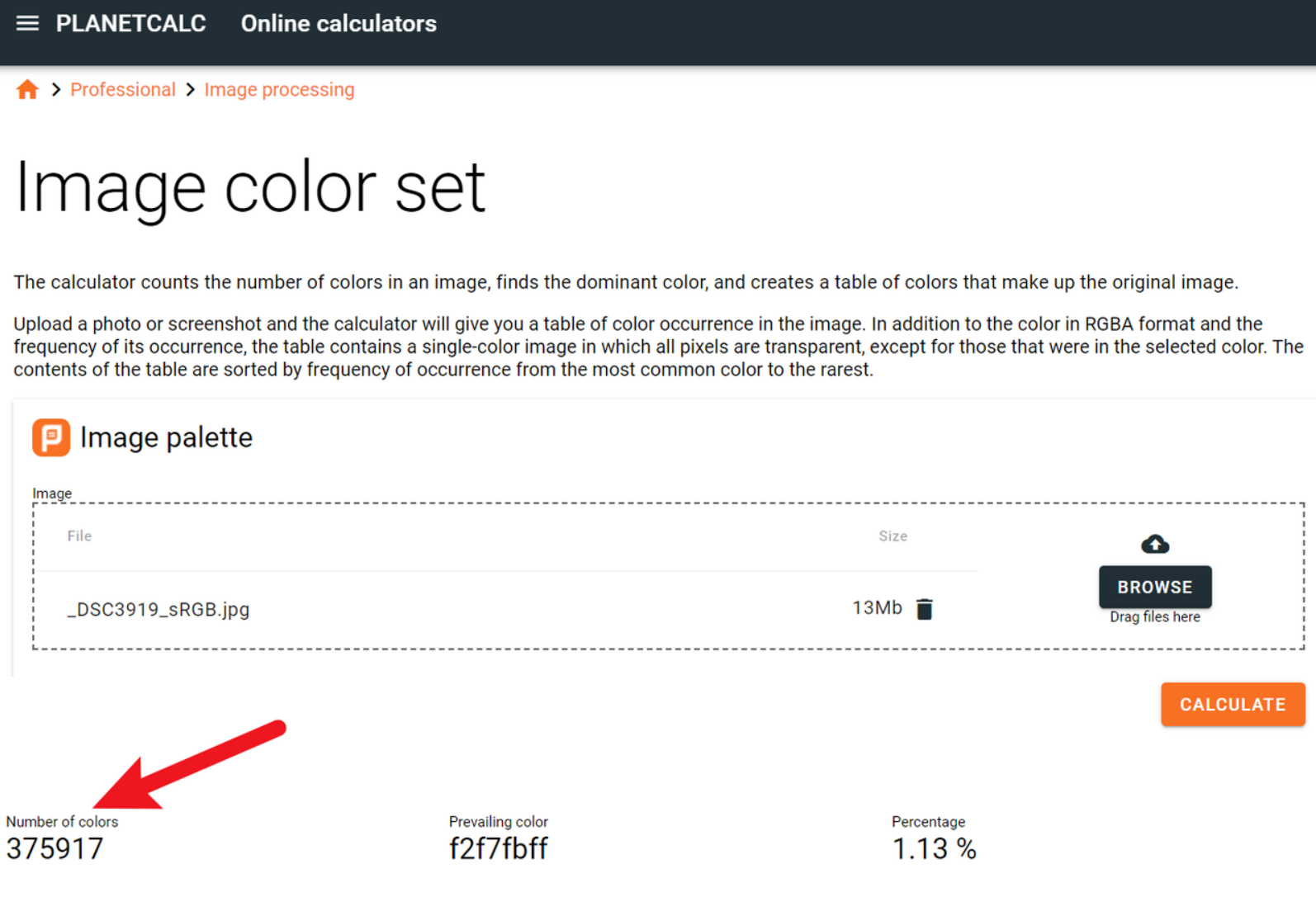

To też jest proste. W prawdziwym życiu bardzo mocno nasyconych walorów barwnych jest mało. Bo gamut oznacza maksymalne nasycenia. Nic więcej. No więc, mocno nasyconych kolorów w zdjęciu jest bardzo mało. Oznacza to, że zajmują one w przestrzeni barwnej głównie środek, im bliżej granic przestrzeni, czyli w stonę wysokich nasyceń, tym odcieni mniej. Jeśli więc zdjęcie renderujemy do coraz szerszej przestrzeni, coraz więcej odcieni jest "zarezerwowanych" dla odcieni o coraz wyższych nasyceniach a ich fizycznie nie ma. Wniosek jaki się nasuwa, to w przestrzeniach węższych jest coraz więcej. I tak jest, wszak z powyższych przykładów, najszersza jest ProPhoto, potem AdobeRGB i najwęższa z nich to DCI-P3. Oznacza to jednocześnie, że w sRGB powinno być najwięcej. I tak właśnie jest:

Ponad dwa razy więcej unikalnych odcieni niż w ProPhoto! Wywaliło to właśnie do góry kołami Wasze dotychczasowe rozumienie obróbki fotografii i operowania przestrzeniami barwnymi? Założę się, że tak. Skąd zatem całkowicie odwrotne przekazy we wszelkich mediach? To trzecia rzecz prosta w niniejszym artykule. Rynek jest rządzony reklamą. Reklama natomiast preferuje proste słowa - klucze, których ludzie nie muszą rozumieć, a tylko identyfikować w osi złe - dobre. Im szersza przestrzeń, tym lepsza, im więcej procent "pokrycia", tym lepiej. Gdyby natomiast napisać, zgodnie z prawdą, że szersza przestrzeń może dawać jakościowo gorsze zdjęcie, więcej procentów wcale nie oznacza lepszej reprodukcji barwnej, wystąpiłaby kolizja słów - kluczy z rozumieniem konsumenta. Mógłby zacząć drążyć. A pytający "dlaczego", to zły klient. Trzeba mu wytłumaczyć, a wówczas wyszłoby na jaw, że powszechnie operuje się manipulacją. I tym optymistycznym akcentem.... :)

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość