FAQ

Tag : gamut

Każde urządzenie na swój sposób przekłamuje kolor, nie ma więc takiego sprzętu, któremu można by bezwzględnie zaufać. Istnieje jednak pewien bezwzględny arbiter, dosyć łatwo demaskujący wszelkie różnice w kolorystyce - ludzkie oko. Możemy na nim polegać gdyż to ono w ostatecznym rozrachunku wpływa na decyzję, czy obraz wygląda dobrze czy źle.

W 1931 roku Międzynarodowa Komisja do Spraw Oświetlenia (Commission Internationale de l'Eclairage - CIE) opracowała model ludzkiej percepcji koloru - tzw. obserwatora standardowego. Model ten posłużył do opisania przestrzeni koloru podobnej do CMYK i RGB. Nosi ona nazwę L*a*b. Za jej pomocą można opisać kolor, tak jak widziałby go człowiek. Do opisu używane są trzy parametry: L (0-100) - jasność, a (-128-127) - kolor od zielonego do czerwonego oraz b (-128-127) - kolor od niebieskiego do żółtego. Przestrzeń L*a*b ułatwia ponadto ocenę wielkości odchylenia barwnego za pomocą urządzeń pomiarowych.

Do każdego zastosowania należy odpowiednio dobierać narzędzie. Jeśli w dziedzinie obróbki obrazu ma być zastosowany monitor LCD, należy wybrać taki, który ma wystarczające do danego zastosowania parametry.

Wierność odzwierciedlenia przestrzeni barw jest jest jednym z najtrudniejszych zadań stojących przed monitorami. Zarówno monitory kineskopowe jak i ciekłokrystaliczne są w tych zastosowaniach wyraźnie podzielone na grupy.

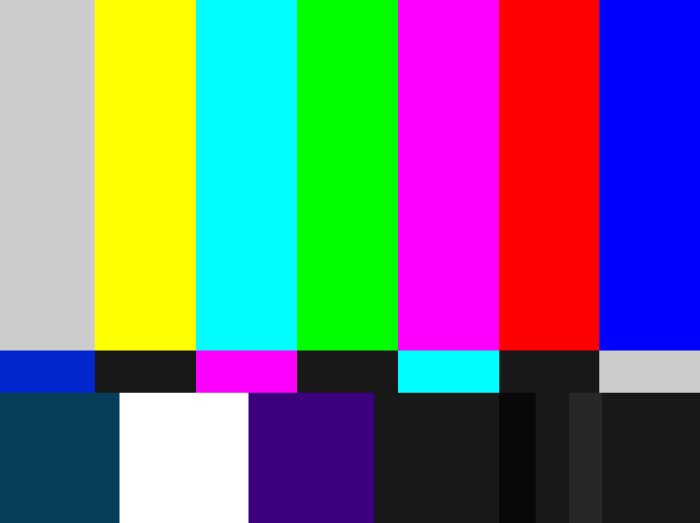

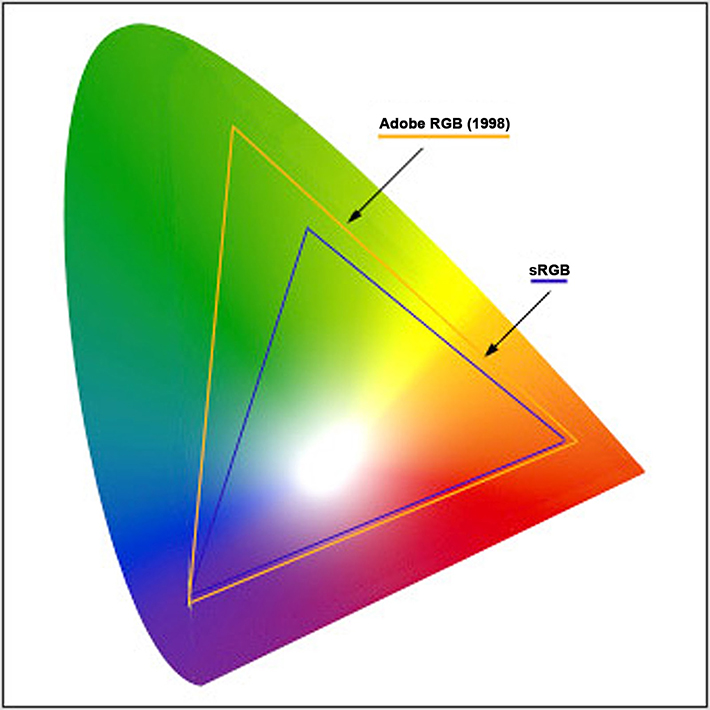

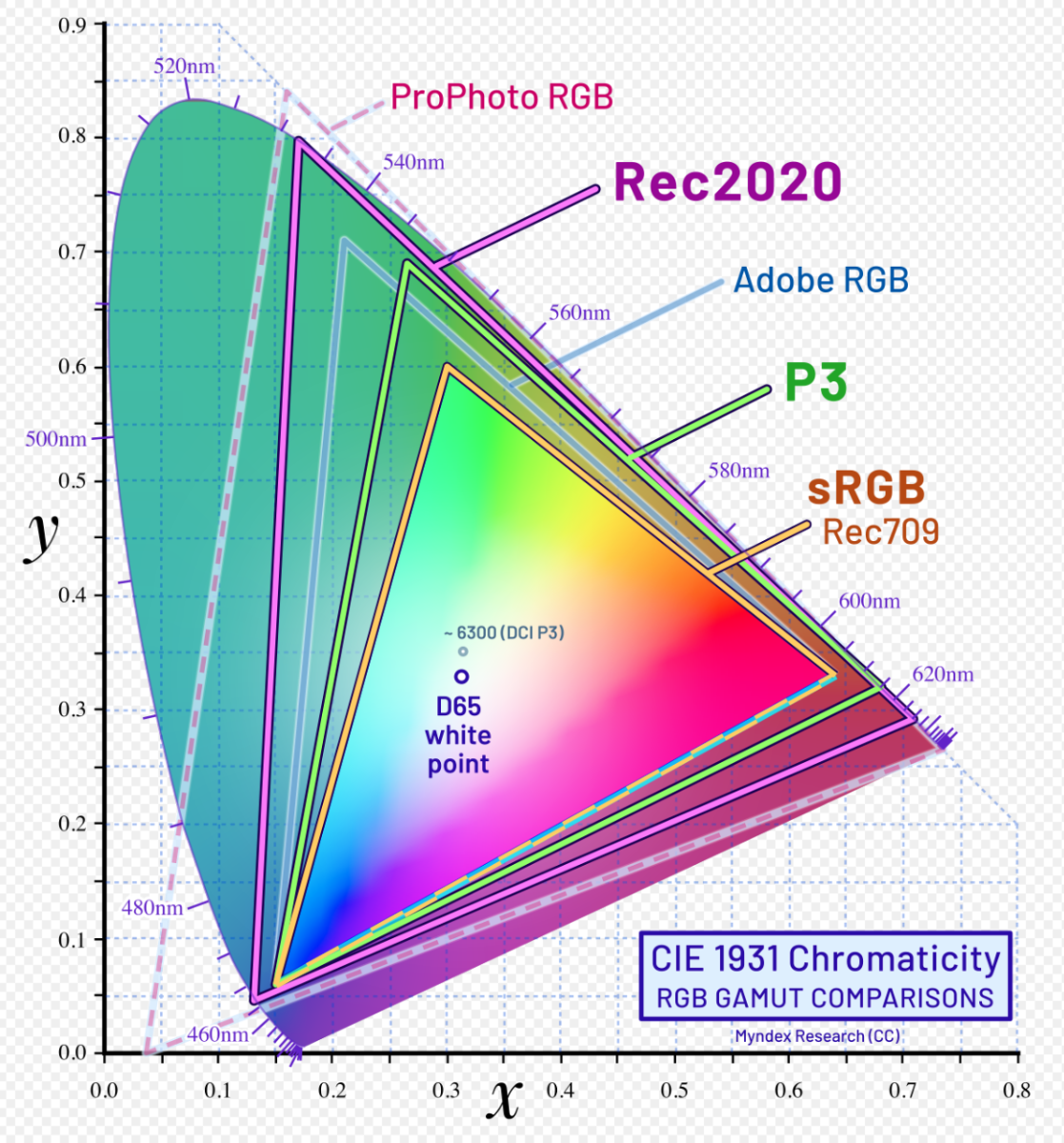

Do większości zastosowań amatorskich wystarczy z powodzeniem wierność reprodukcji w standardzie sRGB, który jest wspólny dla wielu monitorów LCD, CRT, drukarek, skanerów, aparatów cyfrowych itp. Przy zastosowaniach zawodowych ważna jest zdolność szerszego odzwierciedlenia barw. Ogólnym standardem w tej dziedzinie jest przestrzeń barwna określona jako AdobeRGB. Istnieją zarówno monitory CRT jak i LCD pokrywające ten zakres a nawet większy.

Stopień wierności wyświetlanych barw jest tylko jednym z parametrów monitorów. W dziedzinach gdzie nie jest to zbytnio ważne, dom, rozrywka, monitory nie muszą być aż tak dokładne, a przez co mogą być tańsze. Nie należy się spodziewać idealnie wiernych kolorów w niektórych klasach, i to zarówno na monitorach LCD jak i kineskopowych. Światowa tendencja na przejście na LCD spowodowała zalew przez wiele tanich konstrukcji, jednakże nie należy budować opinii w oparciu o wycinek rynku.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Astygmatyzm ma bardzo duży związek z pracą przy monitorze. Wada tego typu to nic innego jak rozogniskowanie wiązki światła wynikająca z nieprawidłowej budowy rogówki lub soczewki ocznej. Budowa ekranu, a co za tym idzie, obrazu generowanego przez monitor, mogą powodować, że "nieostrość" obrazu się potęguje. Przyczyna odczuwania nudności przed monitorem jest fizjologiczna i ma związek z oczami oraz, paradoksalnie, uszami. Otóż, nasz mózg, nauczył się pobierać informacje o położeniu ciała nie tylko z błędnika, organu dedykowanego, ale też z oczu i traktuje je równorzędnie. To nie jest poprawnie, ale mózg tak przyjmuje, gdyż zwyczajowo, informacje z obu ośrodków są spójne i równie wiarygodne. Czasem jednak występuje zaburzenie sygnałów z obu źródeł, np obraz z oczu jest nieprawidłowy, zaburzenie ostrości widzenia, niestabilność obrazu, ale informacja z błędnika mówi, że pozycja jest jednak stabilna, choć obraz jest zniekształcony. Następuje wówcza kolizja danych i te sprzeczne informacje idą do ośrodkowego układu nerwowego. Co ciekawe, sygnały są analogiczne jak przy zatruciu, gdyż toksyny również zaburzają widzenie, jako jeden z pierwszych skutków. Czyli znów, oczy podpowiadają co innego niż błędnik. Zwrotny rozkaz z mózgu jest jednoznaczny - rzygać ile wlezie, aby pozbyć się trucizny. Najbardziej popularny symptom - po alkoholu wielu wymiotuje.

Astygmatyzm ma bardzo duży związek z pracą przy monitorze. Wada tego typu to nic innego jak rozogniskowanie wiązki światła wynikająca z nieprawidłowej budowy rogówki lub soczewki ocznej. Budowa ekranu, a co za tym idzie, obrazu generowanego przez monitor, mogą powodować, że "nieostrość" obrazu się potęguje. Przyczyna odczuwania nudności przed monitorem jest fizjologiczna i ma związek z oczami oraz, paradoksalnie, uszami. Otóż, nasz mózg, nauczył się pobierać informacje o położeniu ciała nie tylko z błędnika, organu dedykowanego, ale też z oczu i traktuje je równorzędnie. To nie jest poprawnie, ale mózg tak przyjmuje, gdyż zwyczajowo, informacje z obu ośrodków są spójne i równie wiarygodne. Czasem jednak występuje zaburzenie sygnałów z obu źródeł, np obraz z oczu jest nieprawidłowy, zaburzenie ostrości widzenia, niestabilność obrazu, ale informacja z błędnika mówi, że pozycja jest jednak stabilna, choć obraz jest zniekształcony. Następuje wówcza kolizja danych i te sprzeczne informacje idą do ośrodkowego układu nerwowego. Co ciekawe, sygnały są analogiczne jak przy zatruciu, gdyż toksyny również zaburzają widzenie, jako jeden z pierwszych skutków. Czyli znów, oczy podpowiadają co innego niż błędnik. Zwrotny rozkaz z mózgu jest jednoznaczny - rzygać ile wlezie, aby pozbyć się trucizny. Najbardziej popularny symptom - po alkoholu wielu wymiotuje.

Astygmatycy, widzący nieostro niejako z natury, są grupą szczególnie podatną na tego typu zakłócenia informacji z sensorów. Astygmatyzm w połączeniu cechą refrakcji, załamującą różne długości fali świetlnej pod różnym kątem, powoduje, że ognisko barwy czerwonej wypada w innym miejscu niż zielonej czy niebieskiej. Efekt - tęczowa nieostrość na krawędziach elementów ekranowych. Finalnie, astygmatycy odczuwają dolegliwości podobne do zatrucia: ból głowy, nudności, czasem wręcz wymioty. Identyczny mechanizm obronny organizmu zachodzi w przypadku choroby morskiej, tylko wówczas zestaw informacji jest odwrotny. Sedno problemu w chorobie morskiej tkwi w zaburzeniach priorytetyzacji informacji z oczu i błędnika. Jeśli odciąć jedną z tych dwóch danych, wszelkie objawy natychmiast znikają. O ile w przypadku choroby morskiej niektórzy mogą się tego nauczyć / przyzwyczaić mózg, w przypadku astygmatyzmu, jest to stałe i ludzie cierpią przed monitorem. Co ciekawe, identyczny problem pojawia się również u osób z zdrowym wzrokiem, choć rzadziej.

W przypadku opisanych uciążliwości podczas pracy z komputerem, należy zniwelować przyczynę, czyli nieostry obraz. Zjawisko astygmatyzmu jest tym mniejsze, im mniejszy gamut monitora (nasycenia barw skrajnych) i jego plamka (piksel). Czyli trzeba w pierwszym rzędzie wybierać monitory sRGB o maksymalnie dużych gęstościach pikseli, 4H UHD, 6K, 8K przy możliwie małych przekątnych. Również, choć rzadziej, astygmatycy źle odbierają niektóre kształty pikseli monitora i odstępy między poszczególnymi subpikselami. Obraz bowiem tworzony jest przez trójkolorowe źródła światła przesunięte względem siebie w przestrzeni. Taka specyfika powoduje większą skłonność do aberracji chromatycznej na siatkówce, co w połączeniu z astygmatyzmem daje większą, również "chromatyczną", nieostrość.

Zalecenia:

• Osobom z zdiagnozowanym astygmatyzmem, nawet w stopniu lekkim, proponuje się korzystanie z monitorów o wąskim gamucie lub szerokogamutowych z kalibrowaną przestrzenią i kalibrację ich do standardu sRGB.

• Jak najwyższą gęstość pikseli monitora. UHD, 4K, 8K, Retina.

• Jasność obrazu na ekranie nie może być wyższa od jasności tła.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Geneza problemu

Problem z laptopami jest taki, że mają z reguły problem z przestrzenią barwną, mniejszą niż sRGB. Przestrzeń natomiast jest to zdolność do pokazywania nasyceń. Pomiędzy ich zdolnością reprodukcji nasyceń a granicą sRGB jest dużo wolnego miejsca. Drobna dygresja - kalibracja tego nie zmienia. Kiedy zwiększa się nasycenia w zdjęciu, sukcesywnie odcienie sie przesuwają w stronę granic gamutu. Im mocniej, tym ruszają się mniej nasycone partie, których w obrazie jest więcej i kiedy one dostaną żądane nasycenie, wszystkie wyższe dawno wyjdą poza przestrzeń możliwą do wyświetlenia. Przestajemy je widzieć i efekt jest taki właśnie, że kolory zaczynają być sztuczne, trawa wygląda jak kamizelki odblaskowe, zachód słońca jak wybuch atomowy itd.

Recepta

Najlepszym wyjściem jest zmiana ekranu roboczego na monitor o sensownej wiarygodności wyświetlania. Niestety nie zawsze jest to możliwe, choćby ze względów finansowych. Dobrą praktyką na laptopie jest takie kręcenie na zasadzie "za mało". Kiedy zdjęcie się wydaje dość mocne, kolor nasycony zgodnie z życzeniem, to znaczy, ze trzeba połowę z tego cofnąć z powrotem, bo oznacza, że jest dużo za dużo. Obraz będzie bardziej "wyprany z koloru" ale tylko na laptopie. Na wszystkich innch ekranach będzie bardziej nasycone niż je widzimy. Jest to praca w sporej części w ciemno, ale taka jest specyfika laptopów.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Wiele lat szukałem dobrego przepisu na kiszone ogórki. Przepisów wszędzie w bród. Każdy blog kulinarny ma w zasobach przynajmniej jeden. Wszystkie oczywiście najlepsze, najsmaczniejsze, jak domowe, od babci itd. Tyle, że nic unikatowego z nich nie wychodzi. Ja natomiast szukałem takiego, aby ogóreczki wyszły chrupiące, aromatyczne, pachnące koperkiem, chrzanem i innymi dodatkami, a nie tylko wykręcające paszczę, kwaśne kapcie puste w środku. Co roku robiliśmy z żoną ogórki, ale dopiero w tym roku, postanowiłem podejść do sprawy naukowo.

Wstęp, ważniejszy niż cała reszta

Przede wszystkim, to co mówią w warzywniakach sprzedając gotowe wiązki kopru z zdechłym chrzanem to ściema. Ogórki się ukiszą, ale to nie wystarczy aby był dobry smak. Na bazie tych "uszlachetniaczy" ogórki wyjdą gorsze niż sami sprzedają jako gotowe. Jeśli ogórek ma być pachnący i jędrny, od czegoś musi nabrać tego aromatu. Ze słonej wody i zwiędłego kopru nie nabierze atrakcji. Nie kupujcie też pod żadnym pozorem gotowych przypraw w torebkach. Tam jest zmielone suszone "coś" i wychodzą fatalnie. Zmarnowanie ogórków. No i oczywiście same ogórki mają być świeże. Najlepiej prosto z pola, ale wiadomo, że z tym może być trudno. Problem jest w tym, że już kilka godzin od zerwania zaczynają zachodzić zmiany degradacyjne. Gwałtownie maleje w nich zawartość cukrów, których i tak w ogórku jest mało. Namnażają się też bakterie gnilne, szczególnie w okolicy kwiatka na czubku. Dlatego ten kwiatek należałoby jak najszybciej usunąć a całość nastawu zrobić jak najszybciej, najlepiej nie później niż dobę od zerwania. Inaczej będzie większa skłonność do gnicia zamiast kiszenia. Rozmiar też ma znaczenie. Warto poprzebierać u sprzedawcy, aby zebrać nieduże, proste, kształtne ogóreczki. Takie zupełnie inaczej się spożywa niż wielkie potwory a i łatwiej zrobić je "na twardo", o czym później. Pamiętajmy, że nie każda odmiana dobrze nadaje się do kiszenia. Najlepsze, np Śremski, Julian, Octopus, Andrus, Borus, mają największą zawartość cukrów i są odporne na choroby.

Ogórki

Moja wersja ogórków jest nastawiona na bogaty smak. Tak, aby ogóreczkami się delektować, żeby nie były tylko mało zauważonym dodatkiem do kanapki. Składniki podaję na kilogram ogórków, łatwo sobie przeliczyć na nastawianą ilość.

A więc po kolei: Młode, świeże, małe ogórki wrzucamy najpierw do zlewozmywaka z zimną wodą. Niech tak sobie postoją minimum godzinę. To jest bardzo ważny etap, gdyż wszelkie niepożądane bakterie żyją w ziemi i przedostają się łatwo na skórkę. Moczenie w wodzie ma dwa skutki. Po pierwsze powoduje odklejenie ziemi przylegającej do skórki, nawet jak jej nie widać gołym okiem. Po drugie powoduje nawodnienie komórek roślinnych, co ma bardzo duży wpływ na prawidłowość dalszych procesów osmotycznych. Po moczeniu myjemy dokładnie pod bieżącą wodą i koniecznie usuwamy resztki kwiatków, siedliska bakterii. Spotkałem się z "nowoczesnymi" przepisami, mówiącymi o skrojeniu koniuszków ogórka z obu stron. Szczególnie takie nowomodne modyfikacje są popularne w poradnikach chcących uchodzić na trendy. Bzdura! Sprawdziłem, nic to nie daje. Pewien sens jest w tym, że odkrajając "dupkę" pozbywamy się goryczki. Tyle, że jeśli trzeba się jej pozbywać, to znaczy, że mamy złą odmianę ogórków. Ogórki do kiszenia nie mają goryczy. Dobrą metodą jest natomiast hartowanie, przez przelanie wrzątkiem i następnie znów wrzucenie do zimnej wody. Wrzątek zabija bakterie z gleby i wydłuża okres przechowywania ogórków, gdyż ogranicza procesy gnilne w ostatnim stadium fermentacji.

Kiedy mamy już umyte ogórki, na dno wiadra lub innego pojemnika wkładamy dodatki, samo clue późniejszego smaku ogóreczków. Uwaga: Pojemnik nie może być metalowy! Ceramiczny lub plastikowy. Ja nastawiam w czym się da. W przepisach są oczywiście często koszerne kamionkowe garnki. Pierwsze próby robiłem w dużym plastikowym wiadrze z pokrywką po jakiejś zaprawie tynkarskiej. Umyłem, wyparzyłem i jest genialne do takich celów. Później znalazłem beczułkę plastikową 30L z zakręcaną pokrywą. Pojemnik nie powinien być bardziej szeroki niż wysoki. Chodzi o to aby zalewa łatwo przykrywała zawartość i dało się od góry włożyć taki talerz, aby miał średnicę podobna do pojemnika, aby lekko przycisnąć ogórki, które inaczej będą miały tendencję do wypływania. Muszą być całe w wodzie. Pojemnik i ilość nastawu należy tak dobrać, aby było jak najmniej powietrza a całość dało się szczelnie zamknąć. Po zakończeniu właściwego kiszenia bowiem, zaczynają rozwijać się drożdże a nastepnie w wyniku obniżenia kwasowości, uaktywniają się enzymy pektolityczne, które powodują gwałtowne mięknięcie a docelowo nawet rozpuszczenie się ogórków. Ot, po prostu zgniją a śmierdziało przy tym będzie, że olaboga. Bakterie uczestniczące w tym procesie lubią tlen, więc po zakończeniu właściwego kiszenia, należy pojemnik zamknąć.

Przyprawy

Dodatki, czyli całe sedno smaku, zapachu, jędrności a i nie tylko. Wiele z przypraw ma właściwości bakteriobójcze, związki polifenolowe, przydatne w procesie kiszenia. Niestety też są źródłem zakażenia bakteriami gnilnymi i pleśnią, więc należy bardzo dokładnie je umyć, w żadnym wypadku nie wrzucać czosnku z uszkodzeniami czy obrośniętego "czymś" chrzanu.

Przypominam, to są miary mniej więcej na kilogram ogórków. Ogólna masa przypraw nie powinna przekraczać 3% masy ogórków. Zbyt duża ilość szczególnie zawierających garbniki może popsuć smak.

- Koper. Najważniejsza przyprawa, zawiera bardzo aromatyczne olejki terpenowe. Należy dać minimum 2-3 całe kopry, wraz z kwiatostanami i łodygami. Nie żałować. Im więcej kopru tym lepszy aromat.

- Duża główka czosnku. Zawiera znaczną ilość olejków eterycznych działających bakteriobójczo i bakteriostatycznie. Nie trzeba obierać. Można przekroić w poprzek całą główkę, ale pod warunkiem, że zachowujemy idealną czystość.

- Korzeń chrzanu. 2-3 kawałki wielkości minimum ok 10cm. Jeśli korzeń jest gruby, można przekroić na węższe paski ok 1 cm grubości. Jeśli jest liść chrzanu, też dobrze. Nie należy przesadzać z ilością, bo oprócz grzybobójczego dobra nazywającego się glikozyd, zawiera też enzym peroksydazę, powodujący trawiasty posmak ogórków.

- Kilka liści laurowych.

- Kilkanascie kulek ziela angielskiego i tyle samo pieprzu czarnego. Jak ktoś lubi ciut na pikantno, można więcej.

- Łyżeczka gorczycy.

- Liście winogron, porzeczek, wiśni, dębu, malin. Liście zawierają garbniki oraz enhibitory enzymów m.in. katalizujących proces maceracji tkanki roślinnej. Po ludzku - czynią ogórki twardymi. Najwięcej garbników zawierają liście malin, porzeczek, najmniej - wiśni. Ja wrzucam liście winorośli, ale to dlatego że rośnie mi w ogródku. Testowałem też wiśnię i dąb.

Liście, szczególnie dębu, dadzą lekkie zabarwienie smaku nietypowe w stosunku do ogórków dostępnych w handlu. Od razu poczujecie różnicę. Wiem, że w mieście ciężko o liście malin czy winorośli, dąb znajdziecie w każdym parku. Warto jednak się potrudzić, bo efekt finalny, jeśli je dodamy, jest porażający. Ogórki robią się twardsze niż surowe! Jeśli nie ma szans na wszystkie liście, trudno, ale proponuję nie rezygnować całkiem, bo będą kapcie, a nie jędrne. Wszystkie dodatki układamy na dno pojemnika i wrzucamy ogórki.

Zalewa solna

Tu nie ma wielkiej filozofii, acz co przepis to inna ilość soli. Wbrew nazwie, ogórki małosolne są dość słone, więc sól jest niezbędna również z nazwy tego co robimy. Ważniejsze jednak jest, że bakterie mlekowe, które czynią cały proces, lubią sól. Chodzi o to, aby w początkowym okresie fermentacji jak najwięcej naprodukowało się bakterii mlekowych i szybko podniosły kwasowość zalewy. Ogranicza to rozwój niepożądanych kultur bakterii, w tym gnilnych. Aby fermentacja właściwa zdominowała cały ten biochemiczny reaktor, ilość soli musi być odpowiednia, czyli dość sporo. Poza tym, w czasie procesu, słoność ogórków będzie się bardzo mocno zmieniać. Najpierw, jak tylko zacznie się robić dobrze, ogórki 1-2 dniowe będą małosolnymi i będą bardziej słone. Później, jak zalewa będzie coraz bardziej wnikać w ogórki, siłą rzeczy jednostkowa ilość soli na masę całości będzie się zmniejszać i subiektywne wrażenie słoności będzie mocno malało. Początkowy roztwór powinien zawierać 3 do 7% soli wagowo. Miara na łyżki jest zbyt niedokładna. Jedna sól jest grubsza, inna bardziej miałka i mierzenie objętościowe jest bez sensu, różnice mogą być bardzo duże. Trzymajmy też miarę, bo 1% różnicy w ilości soli przy małym nastawie to może być mniej niż jedna łyżka, ale daje gigantyczną różnicę smaku. Lepiej posłużyć się wagą kuchenną. Ilość soli jest zależna od sposobu ułożenia ogórków. Jeśli ktoś się będzie starał ułożyć je ciasno, zalewy będzie mniej, więc musi zawierać więcej soli. Jeśli będą wrzucone luzem, wówczas soli może być mniej, w dolnej granicy normy. Ja daję ok 3,8% przy ogórkach wsypanych luzem do beczki. Jeśli ktoś chce super purystyczne podejście, to zasada jest taka, że soli ma być tyle, aby w końcowym etapie, już po ukiszeniu, soli w wodzie było 1,8%. No, ale laboratorium nie mamy, więc olać.

Sól może być jakakolwiek, nie ma sensu słuchać durnych eko-trendów typu wyłącznie sól himalajska, morska i tym podobne pierdoły. Zwykła najtańsza z "biedry" działa jak trzeba. Jedynie, może niekoniecznie ze względu na różnicę w parametrach kwaszenia, ale wydaje się sensowne nie stosować soli z dodatkami przeciwzbrylającymi, zawierającej niezdrowy E536, żelazocyjanek potasu. Natomiast co ważne, woda musi być dobrej jakości. Jeśli z płytkiej studni lub jeśli są podejrzenia o jej niezbyt dobrą czystość biologiczną - przegotowana. Również nie słuchajmy modnych "blogerek", które mówią o "świeżej wodzie". Może jeszcze z górskiego potoku? Normalna woda z wodociągu zawiera wolny chlor i jeśli nie gotujemy, należy odstawić ją na kilka godzin a nie zalewać. Bakterie mlekowe są bardzo wrażliwe na działanie kwasu podchlorowego i to daje korzystne warunki do mnożenia się bakterii niepożądanych. Woda nie może być też zbyt miękka. Jeśli mamy miękką wodę, poniżej 12 stopni niemieckich i na dodatek przegotowaną, czyli z usuniętą częścią wapnia, należy dodać kilka gram chlorku wapnia. Dostępny w sklepach chemicznych. Bez obaw, to nie jest szkodliwa chemia. W większości miast woda wodociągowa ma ok 14-15'n, więc nadaje się od razu.

Ciekawym dodatkiem do zalewy jest cukier. Bardzo rzadko o nim wspomina się w "babcinych przepisach". Jest nieocenionym dodatkiem aby szybciej zainicjować pierwszą fazę kiszenia i ograniczyć rozwój bakterii niepożądanych. Należy dodać 0,5-1% na ilość roztworu.

Wody przygotowujemy tyle, aby przykryć ogórki z dobrym zapasem. Zapas wody będzie potrzebny później, wyjaśnienie w ostatnim akapicie. Nie rozpuszczajcie też soli w czasie gotowania wody bo nawet nierdzewny garnek zacznie rdzewieć. Najlepiej sól rozpuścić na koniec, kiedy woda już przestygnie. Zawartość pojemnika zalewamy wodą, nie gorącą, można lekko ciepłą, ale im chłodniejsza tym lepiej, przykrywamy talerzem na który warto położyć mały kamień, aby nic nie wypłynęło i odstawiamy w spokoju.

Pierwsze efekty

Pierwsze małosolne są już gotowe po półtorej dnia. Obok, na zdjęciu moja beczka po dwóch dniach. Niektórzy lubią takie ledwo-ledwo, kiedy jeszcze nawet nie zmienią koloru i są jeszcze intensywnie zielone. Swoją drogą, czy wiecie, że właśnie zielenie w czasie obróbki fotografii na monitorach, najłatwiej wychodzą na granicę gamutu i zaczynają wyglądać jak "radioaktywne"? Trawa ma tendencję do nabierania odcienia jak kamizelki odblaskowe, znikają detale, wszystko zaczyna się robić płaskie i oczojebne. Także ostrożnie z podkręcaniem saturacji, szczególnie na laptopach, bo skutki bywają kiepskie. Laptopy mają najczęściej przestrzenie mniejsze niż sRGB i chcąc uzyskać "mocny", "kalendarzowy" kolor, ostro się manipuluje suwakami. Z uwagi na to, że najwyższych nasyceń taki panel w ogóle nie wyświetla, cała grupa mniej nasyconych odcieni po podkręceniu, "przylepia" się do granicy gamutu i wygląda to później fatalnie.

Pierwsze małosolne są już gotowe po półtorej dnia. Obok, na zdjęciu moja beczka po dwóch dniach. Niektórzy lubią takie ledwo-ledwo, kiedy jeszcze nawet nie zmienią koloru i są jeszcze intensywnie zielone. Swoją drogą, czy wiecie, że właśnie zielenie w czasie obróbki fotografii na monitorach, najłatwiej wychodzą na granicę gamutu i zaczynają wyglądać jak "radioaktywne"? Trawa ma tendencję do nabierania odcienia jak kamizelki odblaskowe, znikają detale, wszystko zaczyna się robić płaskie i oczojebne. Także ostrożnie z podkręcaniem saturacji, szczególnie na laptopach, bo skutki bywają kiepskie. Laptopy mają najczęściej przestrzenie mniejsze niż sRGB i chcąc uzyskać "mocny", "kalendarzowy" kolor, ostro się manipuluje suwakami. Z uwagi na to, że najwyższych nasyceń taki panel w ogóle nie wyświetla, cała grupa mniej nasyconych odcieni po podkręceniu, "przylepia" się do granicy gamutu i wygląda to później fatalnie.

Po kolejnych około 2 dniach, kiedy fermentacja wchodzi w fazę właściwą, ogóreczki zaczynają już być takie jak lubię, czyli zmienią kolor i zacznie być wyczuwalny aromat całego dobra, jakie włożyliśmy do środka a jednocześnie nie są jeszcze hiper ukiszone. Czas jest zależny od temperatury. Im cieplej, tym proces przebiega szybciej, ale nie powinno się nastawiać w upały. Temperatura powyżej 25 st nie jest korzystna. Nie można też trzymać ich w cieple za długo, bo będą coraz mocniej kwaśniały oraz zaczną rozwijać się drożdże i szybko fermentacja przejdzie w dalsze fazy, czego, uwierzcie na słowo, na pewno nie chcecie. Oczywiście, jeśli ktoś lubi, można jeszcze chwilę zaczekać, ale moim zdaniem trzymanie ich w ciepłym miejscu tydzień, da ogórki, które o ile nie zaczną jakimś cudem gnić, nadadzą się tylko na zupę. Warto wiedzieć, że po zakończeniu fermentacji mlekowej, reakcja wcale się nie zatrzymuje. Idzie sobie dalej, ale w niezbyt pożądaną stronę, czyli rozwój bakterii gnilnych, fermentacja masłowa, octowa itd. Bardzo częstym błędem jest trzymanie pojemnika w kuchni zbyt długo i zamiast cudownego aromatu, z wiadra zaczyna zalatywać nieładnie, jakby ktoś puścił bąka. Po maksymalnie kilku dniach (48-72h) całe wiadro trzeba przestawić w chłodne miejsce, np do piwnicy. Na tym etapie należy szczelnie zamknąć pojemnik. Dopóki w czasie prób smakowych wyczuwa się jakby były szczypiące "gazowane", póty jeszcze reakcja idzie w najlepsze. Nie przejmujcie się jeśli woda zmieni kolor na brązowawy, tak ma być, liście dębu to powodują. Nie przejmujcie się też pianą. Nic nie należy zbierać z powierzchni, nie mieszać też, aby nie natleniać nastawu. Przypominam, że drobnoustroje niepożądane to bakterie tlenowe.

Detailing

Teraz kolejny z kluczowych kroków. Kiedy ogórki są już blisko-blisko żądanego stopnia zakwaszania, moim zdaniem, kiedy już zmienią kolor z żywo zielonego, problematycznego w sRGB podczas zbyt agresywnej obróbki, na swój właściwy, koniecznie obniżamy temperaturę. Najlepiej zapewnić warunki chłodnicze, ale mało kto zmieści wiadro do lodówki. Wyciągamy je więc z wiadra i ile się da wrzucamy do największego plastikowego pojemnika na żywność jaki się zmieści do lodówki. Ważne aby miał szczelną pokrywę. Wrzucamy ogóreczki, zalewamy wodą z wiadra (po to potrzebny jej zapas), zakrywamy i wstawiamy do lodówki. To bardzo ważny moment, bo w niskiej temperaturze zatrzymają się dalsze etapy fermentacji a i na zimno są dużo smaczniejsze niż w temperaturze pokojowej. Po jednym dniu w lodówce, niebo w gębie. Coś cudownego.

Jeśli zrobiliśmy więcej niż się zmieści do lodówki, wiadro zostawiamy w piwnicy w jak najchłodniejszym miejscu. Im zimniej tym dłużej postoją. Jeśli będzie za ciepło, okres przechowywania mocno się skróci. Będą tam sobie powolutku dojrzewać i po zjedzeniu tego co w lodówce, idziemy po kolejną porcję. Ja nastawiam, zależnie w wiadrze czy beczce 5-10 kg i po kilka razy dokładam do lodówki. W tej sposób mam kilka wersji zakiszenia, trudno powiedzieć które lepsze.

Przepis jest wynikiem moich wielu eksperymentów i szukania najlepszego smaku. Szczerze zachęcam do sprawdzenia, jest spora szansa, że spodoba się Wam taka wersja. :)

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Baju, baju...

Zacznijmy od tego, że sformułowanie "pełny gamut", czy "100% pokrycia" to ściema najwyższego sortu. Sugeruje, że coś jest "pełne", czyli dobre, pożądane, a wszystko inne jest z automatu okrojone, niepełnowartościowe. Użycie takiego określenia w kontekście przestrzeni barwnej wyraźnie każe myśleć, że montor wyświetla "pełną paletę", "100% sRGB" czyli wszystkie kolory z palety, jest najlepszy, lepiej już się nie da. Nie owijając w bawełnę, jest to ordynarne kłamstwo!

Problematyczne sformułowanie jest luźno naciągnietą interpretacją z procentowego pokrycia przestrzeni barwnej, która w strasznie wykoślawionej postaci, obecnie dzierży palmę pierwszeństwa wśród parametrów technicznych monitorów. Marketingowo forsowanym sposobem rozumienia jest, jakoby monitor wyświetlał 100%, czyli wszystkie odcienie zadeklarowanej przestrzen sRGB, AdobeRGB lub modnej teraz P3 DCI. Tymczasem, gamut to tak naprawdę tylko zdolność do produkowania nasycenia (saturacji). Jeśli monitor ma objętość bryły gamutu podobną np do AdobeRGB, podaje się stosowną różnicę procentową. Przy czym, w tym "parametrze" wcale nie chodzi o zgodność z AdobeRGB a tylko podobny poziom nasycenia, inaczej objętość bryły przestrzeni barwnej, zakreślonej właśnie maksymalnie nasyconymi odcieniami. Czyli np maksymalnie nasycony odcień czerwony, może lecieć w rzodkiewkowy albo inny buraczkowy, ale będzie miał podobne nasycenie względem "prawidłowej" czerwieni i wyjdzie, że jest to 100% pokrycia, choć tak naprawdę wyświetli odcienie niepodobne do tego co powinien.

Najważniejszym wnioskiem jest, aby wiedzieć, że żadne "pełne gamuty" nie mają zupełnie związku z jakością wyświetlania obrazu. Jest to parametr ilościowy a nie jakościowy. Nasycenie, gęstość optyczna, dwóch odcieni może być podobna, ale już same odcienie mogą być inne.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Ciągle gdzieś się przewija termin KALIBRACJA. Wszędzie masa szkoleń, pokazów, materiałów, mówiących jakie to jest proste albo wręcz zbędne, bo sprzęt jest już skalibrowany fabrycznie. Niedawna dyskusja na jednym z for, skłoniła mnie do napisania jak to jest ze znaczeniem kalibracji.

Pomimo wielu lat tłumaczenia, ciągle są nieporozumienia. Od strony potocznej, kalibracja jest, co prawda nieprawidłowo, ale rozumiana jako doprowadzenie czegokolwiek do żądanego stanu. Czyli na przykład ustawienie jaskrawości na 200nitów i potwierdzenie tego miernikiem jest kalibracją tego parametru. W kontekście ekranów monitorów, kalibracji można poddać następujące parametry:

W monitorach profesjonalnych:

- współrzędne chromatyczne punktu bieli

- współrzędne chromatyczne punktu czerni

- współrzędne chromatyczne kanałów RGB

- wierzchołki a czasem również kształt bryły gamutu

- jasność bieli

- jasność czerni

- zakres i poziom dynamiki

- rodzaj krzywej odpowiedzi tonalnej

- wiele innych mocno zagadkowych wielkości

W monitorach amatorskich:

- poziomy wysterowania kanałów RGB, wpływających na punkt bieli

- czasem wykładnik funkcji "gamma", będącą jedną z krzywych odpowiedzi tonalnej

- jasność bieli

W laptopach:

- jasność bieli

W każdym przypadku kontrolowanej zmiany czegokolwiek, będziemy już mieli do czynienia z kalibracją tejże wielkości. W przypadku sprzętu "skalibrowanego fabrycznie", właśnie w ten sposób się reguluje. Normalny użytkownik nie widzi rozróżnienia w zaawansowaniu procedury kalibracji i traktuje ją zerojedynkowo. Skalibrowany to skalibrowany i kwita. Niezależnie w jakim stopniu będzie zrobiona kalibracja, co i jak było zmieniane i po co, użytkownik postrzega fakt kalibracji zawsze tak samo. To nie koniec nieporozumień. Kalibrację parametrów obrazu można zrobić do dowolnych parametrów. Możemy na przykład ustawić obraz:

- punkt bieli x=0.276, y=0.289

- jasność bieli 233 cd^m2, jasność czerni 5 cd^m2

- krzywa odpowiedzi tonalnej ɤ = 2,9

To jest przykład skrajny, ale formalnie, wyregulowany w ten sposób obraz będzie przecież skalibrowany! Co z przydatnością jeśli ktoś pragnie pracować przy owym skalibrowanym ekranie? Oczywiście będzie zerowa, bo tak ustawiony ekran będzie miał super jaskrawą będącą ekwiwalentem ponad 10 000K z gigantycznymi kontrastami. Monitory kalibrowane fabrycznie również mają podobny zestaw parametrów z sufitu, acz oczywiście nie tak absurdalny. Dochodzimy w tym miejscu do momentu, kiedy samo pojęcie kalibracji nie jest jednoznaczne nie tylko ze względu na zakres i rodzaj regulacji, ale również celu kalibracji. Fabrycznie przyjęte typowe parametry typu 6500K, 80, 2,2 nie muszą przecież pasować zawsze i każdemu. O tym dopasowaniu decydują docelowe zastosowania, uwarunkowania oświetleniowe miejsca pracy i samego użytkownika. To jest bowiem faktycznym celem kalibracji. Użytkownik, decydując się na pracę ze skalibrowanym sprzętem, w domyśle, chce optymalnie i neutralnie widzieć materiały nad jakimi pracuje. Na tym etapie pojawiają się znaczne zmiany procedury i nie ma żadnej przesady w uświadamianiu, że jest to bardzo skomplikowany zestaw prac.

Kalibrację w ujęciu jaką chcą mieć użytkownicy i faktycznie odbiorcy tego rodzaju usługi, należy rozumieć przez regulację samego sprzętu. Oczywiście z uwzględnieniem zastosowań, środowiska gdzie ma pracować i najlepiej z uwzględnieniem specyficznych uwarunkowań fizjologicznych i psychologicznych samego użytkownika. Z uwagi na występowanie trudnych do usystematyzowania zmiennych, w tym najgorszego "czynnika ludzkiego", poprawne ustawienie całości nie jest banalne. Nie powinno mówić się o "kalibracji" w kontekście przypadkowo wyregulowanego ekranu bo nie tego oczekuje ten, który będzie potem przy nim pracował.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Niniejszy artykuł jest uzupełnieniem wiedzy z poziomu popularnego, zaprezentowanego w wpisie: Wersja amatorska

Niniejszy artykuł jest uzupełnieniem wiedzy z poziomu popularnego, zaprezentowanego w wpisie: Wersja amatorska

Kalibracja formalnie

Tak naprawdę, przez błędnie rozumiane zapożyczenie z języka angielskiego, powszechnie przez kalibrację rozumie się regulację. Sprzyja temu samo słowo "kalibracja", które sugeruje czynność - czasownik. Na dokumentach zatytułowanych "Calibration report" lub podobnie, powinniśmy widzieć badany parametr oraz błąd. Wówczas dokument jest technicznie dowodem kalibracji, czyli wyznaczeniem poziomu błędu. To ważna różnica, gdyż formalnie kalibracja nie oznacza kompensacji błędu, a tylko jego określenie. W języku polskim odpowiednikiem jest termin "wzorcowanie". Najprościej to sobie wyobrazić na przykładzie. Kupujemy termometr: Jeśli z termometrem dostaniemy dokument kalibracji / wzorcowania, na którym będzie napisane dT 2 0C to oznacza, że ten termometr przekłamuje o 2 0C. Nie został jednak dostrojony o 2 stopnie błędu, tylko ten błąd jest wyznaczony.

Co jest więc kompensacją błędu, przypisaną niechcący do pojęcia kalibracji? Strojenie / adjustacja / regulacja / adjustment. Czy to ważne? Uważam że tak. Uporządkowanie terminologii jest niezbędne aby przejść do dalszych etapów. Kto słyszał o wzorcowaniu monitorów? No właśnie. A to tylko czubek góry lodowej, bo możemy dostać dokument kalibracji w ogóle bez podanego błędu. Czym jest wówczas?

Konieczne porządki w znaczeniu terminów

- Calibration / kalibracja / wzorcowanie - określenie poziomu błędu

- Adjustment / strojenie / adjustacja - korekcja błędu

- Measurement / pomiar - badanie stanu zastanego

Idę o zakład skrzynką piwa, że zupełnie nikt się nie zastanowił, dlaczego na dokumentach "kalibracyjnych" monitorów praktycznie nigdy nie ma mowy o "adjustment" a tylko "calibration" i "measurement". Jedynym znanym mi wyjątkiem jest firma EIZO. Czyżby w angielskojęzycznym świecie nie istniała czynność strojenia? Wytłumaczenie jest dość proste. Producenci z oczywistych względów wolą "adjustment" wykonywać "wewnętrznie", nie ujawniać detali technicznych. Jest to zrozumiałe, ale również zapewnia ochronę jeśli to strojene jest niekoniecznie idealne a nawet, jeśli nie ma. Nikt nie wie co ze sprzętem się robi i czy w ogóle. Jeśli przy drogim moniotrze jest wzmianka o "adjustment" a przy tańszej wersji nie, to jest to mniej korzystne, niż nie napisać o strojeniu w żadnym z nich. W drugim przypadku nie ma pytań, dlaczego tańszy nie jest strojony, albo wręcz sugeruje, że oba są strojone. Proste?

Jak należy rozumieć to co daje producent?

Terminologię należy rozumieć dosłownie, ale z poprawką na różnice znaczeniowe oraz zniekształcenia zakorzenione na rynku. Jeśli widzimy dokument zatytułowany "Certification report", "Calibration report", "Calibration factory" lub podobniy, nie sądźmy, że jest to dokument poświadczający dostrojenie monitora. Nie oszukujmy się, że ktoś pomylił pojęcie kalibracji i strojenia. W fabryce nie pracują idioci. Jeśli piszą o kalibracji, to jest kalibracja a nie strojenie. W terminologii technicznej są to dwie osobne rzeczy. Również w dokumentacji technicznej nie stosuje się zwrotów potocznych. Czyli, ktoś napisał "calibration", to miał na myśli oszacowanie błędów, a nie ich dostrojenie. Jeśli chciałby pisać o strojeniu, to by napisał. Konkretnie, papier kalibracji, jest to informacja o stanie zastanym produktu. Nic ponadto ów dokument nie mówi. Sprzęt równie dobrze może być po adjustacji, przy całkowicie dowolnym poziomie jakościowym, lub bez regulacji w ogóle, tylko mniej lub bardziej dokładnie pomierzony.

Czyli nie dostaję monitora "fabrycznie skalibrowanego"?

Najczęściej, rzecz jasna - nie. Nie w rozumieniu "dostrojony". W przypadku high-endowych monitorów faktycznie producentowi zależy, aby nie dostarczać na rynek sprzetu rozjechanego i reguluje je sztuka w sztukę już w fabryce. Do tego często dokłada dość szeroką informację o wykonanych pomiarach i błędach przy kontroli jakości: Przykład NEC PA311D, Przykład EIZO CG248-4K Dotyczy to jednak tylko bardzo nielicznych i bardzo drogich monitorów profesjonalnych. Można je policzyć na palcach. Przy całej rzeszy tanich, jakość dostrojenia fabrycznego jest wprost proporcjonalna do ceny a w najniższych modelach, robione jest to po łebkach, lub wcale. Ale dokument "Calibration" jest i formuła tego terminu, plus powszechny brak zrozumienia, daje potężne narzędzie dla całej branży reklamy.

Kalibrować "skalibrowany"?

Jak najbardziej! W stosunku do kalibracji fabrycznej można najczęściej osiągnąć wyraźnie wyższe parametry niż pokazane na "certyfikacie". Jak wspomniałem wyżej, monitory cześciej bywają źle strojone lub nie strojone w ogóle. To nie jest niedoróbka ani zła wolna, tylko względy ekonomiczne. Można zbudować indywidualne stanowiska do strojenia high-endu, sprzedawanego w małych ilościach, ale jest to niewykonalne w przypadku klas niższych, sprzedawanych w setkach tysięcy sztuk. Sprzęt najczęściej ma wyższe parametry niż deklaruje fabryka. Dopiero dostrajając parametry otrzymamy maksymalne możliwości sprzętu. W przypadku nieprofesjonalnych klas monitorów taka adjustacja jest wręcz niezbędna, aby w ogóle mówić o przydatności w pracy.

Zostałem oszukany?

W pewnym sensie tak. Marketing rządzi ludźmi, wtłacza terminy często sprzeczne z ich prawdziwym znaczeniem. Jeśli kupujesz monitor z dokumentem "Fabrycznej kalibracji", wszystko wokół będzie Ci wmawiać, że jest "skalibrowany". Pamiętaj, że producent pisze świadomie i precyzyjnie "calibration", ale rynek wtłacza abyś rozumiał to jako "strojenie".

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Czy małe "pokrycie" to problem?

Nie tylko BenQ stawia na wysokie "pokrycie". Są również laptopy o ekwiwalencie ponad 100% AdobeRGB i są profesjonalne monitory graficzne z 70% AdobeRGB. Co z tego wynika? Czy monitor graficzny "70% Adobe" kosztujący np 10 tys zł, będzie mniej wiarygodny od laptopa za 1 tys zł z 100% AdobeRGB? Dziwne pytanie prawda? Rozsądek podpowiada, że lepszy będzie drogi graficzny, ale jednak parametry na papierze temu przeczą. Czy tak jest rzeczywiście?

Rzeczywistość a przekaz reklamowy

Na początek, warto wiedzieć, jak nie wpadać w pułapkę reklamy, która forsuje dwa główne kierunki przekazu:

• Teza 1: Gamut przekłada sie na jakość wyświetlania.

• Teza 2: Różnica między sRGB a AdobeRGB jest bardzo duża.

Obydwie te tezy są FAŁSZYWE! Rozpatrzmy co w rzeczywistości oznaczają pojemności gamutów i jakie jest ich znaczenie.

Gamut nie przekłada się na jakość wyświetlania.

Przede wszystkim gamut nie ma bezpośredniego związku z jakością generowaina odcieni koloru przez ekran monitora. Gamut to są tak naprawdę nasycenia. Może zaistnieć sytuacja, że monitor o wyższym gamucie może wyświetlać np kolor czerwony bardziej nasycony, ale odcień będzie w kolorze rzodkiewki, a monitor o niższym gamucie będzie wyświetlał ten sam kolor mniej wysycony, ale w odcieniu wozu strażackiego. Pomimo, że odcień maksymalnie czerwony (255,0,0 RGB) ma w rzeczywistości wygląd bardziej jak wóz strażacki, a nie rzodkiewka, to ten pierwszy choć przekłamujący, będzie miał więcej "procentów pokrycia".

Ogólnie, gamut należy rozumieć jako kryterium ilościowe, a nie jakościowe. Co lepiej posiadać, szklankę diamentów czy wiadro węgla?

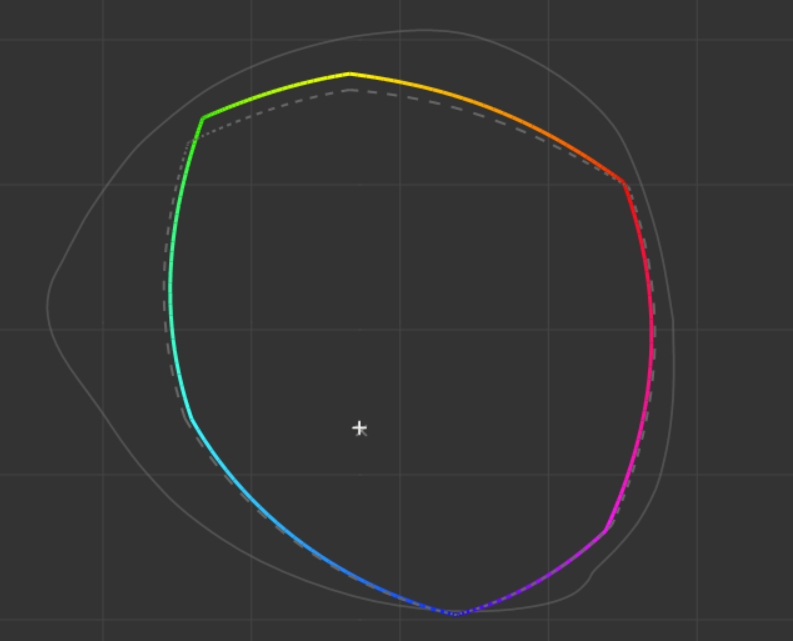

Różnica między sRGB a AdobeRGB jest stosunkowo niewielka.

Mapy CIE Lab przestrzeni sRGB i AdobeRGB na rysunkach różnią się ogromnie co widac na górnej ilustracji. Percepcja jednak inaczej działa przy odcieniach mało i mocno nasyconych. Mało nasycone, rozróżnia się bardzo wyrażnie, nawet kiedy różnice są minimalne, np odcienie skóry, ale mocno nasycone rozróżnia się wielokrotnie słabiej. Posumowując, człowiek rozróżnia wielokrotnie mniej odcieni mocno nasyconych niż słabo nasyconych.

Na diagrame obok pokazana jest przestrzeń AdobeRGB (linia kolorowa) względem sRGB (linia przerywana) w modelu barwnym Din99, znacznie lepiej pokazującym jak naprawdę człowiek widzi. Różnica jest wyraźnie mniejsza niż w wizualizacji w/g CIE Lab, rysunek górny.

Nawał przekazu reklamowanego jest taki, że jak się człowiek naczyta internetu, to wyjdzie że jak nie ma „czarodziejskich" 99% Adobe to dno, wodorosty i nic nie widać. To oczywiste bzdury i wręcz postawienie na głowie reklamy względem rzeczywistej wiedzy fizycznej i medycznej. Jak wspomniałem, percepcja nie działa jak reklama. Najbardziej nasycone odcienie AdobeRGB od sRGB różnią się wizualnie zaledwie o kilka odcieni. Dlaczego więc nie stosuje się modeli matematycznych bardziej zgodnych ze specyfiką ludzkiego widzenia? Przecież takie są, tylko po co zabijać kurę, która znosi złote jajka?

No to jak z tymi monitorami? Który bardziej profesjonalny?

W przytoczonych przykładach BenQ SW270C i NEC EA271U COLOR, to właśnie NEC prezentuje bardziej profesjonalne podejście do tematu, bo zastosowanie matrycy szerokogamutowej jest związane z koniecznością zaawansowanej (i kosztownej) komepnsacji tzw „mury” chromatycznej. Inaczej mamy na powierzchni kolorowe przebarwienia. W klasie monitorów amatorskich takiej elektroniki się nie stosuje, więc przy zastosowaniu panelu o przestrzeni zbliżonej do sRGB, uzyskuje się dużo lepszą finalną reprodukcję. BenQ natomiast odpowiada na oczekiwania rynku, na którym lansuje się fetysz „procentów pokrycia”.

Inna sprawa, kiedy potrzebne jest śrubowanie odcieni do AdobeRGB i wyżej? Odcienie o nasyceniach wychodzących poza sRGB zdarzają się np. w proofingu na tkaninach. W większości normalnych zastosowań prawie nigdy.

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

Magia przestrzeni barwnych i gamutów

Kiedyś było jakoś lepiej

Stare powiedzenie, prawda? Szczególnie wśród nieco bardziej dojrzałej młodzieży. Monitory z czarno-białych stały się kolorowe i stało się cudownie. Nic więcej do szczęścia nie było potrzebne. No, może ekran o większej przekątnej. O jakości wyświetlanych kolorów zupełnie nikt nie myślał. Super, że w ogóle były.

Więcej = lepiej!

Tak się powszechnie uważa. No, chyba, że więcej rachunków za prąd, wówczas niekoniecznie. Ogólnie, w temacie koloru, kolorów, barw, zdaje się być oczywistym, że więcej odcieni, większy gamut oznacza wyższy poziom obróbki fotografii. Nawiasem mówiąc używane zamiennie terminy "przestrzeń" i "gamut" mają inne znaczenie. Kto o tym wiedział? Będzie na ten temat osobny mini-artykuł, poszukajcie w FAQ.

Więcej = lepiej?

Znak zapytania przy oczywistym stwierdzeniu? Nieprzypadkowo. Otóż jeśli weźmiemy pod uwagę takie terminy jak przestrzeń i kolory, to okazuje się, że za bardzo chcą iść w parze.

Więcej kolorów

Pisząc kolory, mam na myśli ilość kolorów w zdjęciu. Przestrzenie barwne zawierają konkretną ilość odcieni. Przestrzenie są podzielone (kwantyzowane) na odcienie co 1 dE. Coś jak metrówka podzielona na milimetry. To zgrubne wyjaśnienie, ale na potrzeby tego opracowania, wystarczy. Czyli, im większa przestrzeń, dłuższa metrówka, tym pomieści więcej odcieni. Przy czym, teoria mówiąca o wyświetlaniu 16,77 mln (zapis 256 odcieni na kanał, czyli zapis 8 bitowy) lub 1 mld kolorów (1024 odcieni na kanał, czyli zapis 10 bitowy) to w praktyce fikcja, bowiem docelowo w przestrzeni sRGB mieści się ok 800 tys odcieni a w AdobeRGB około 1,2 mln odcieni. Bardzo ważne: To są ilości odcieni możliwe do rozróżnienia przez człowieka. Tyle zatem rozróżnimy maksymalnie odcieni w zdjęciu. Więcej może być, ale i tak ich nie będzie widać.

Więcej przestrzeni

Internet twierdzi, że jeśli urządzenie wyświetlające nie wyświetla  ileśtam procentów (najczęściej 99% pokrycia) AdobeRGB, DCI-P3, sRGB, czy bogowie koloru wiedzą czego, to jest źle, dno, woodorosty i nic na takim ekranie nie widać. To nieprawda, a raczej marketingowe niedopowiedzenie, o czym traktuje ten artykuł: Czy monitor powinien miec pełny gamut kolorów, pokrycie 100% sRGB, AdobeRGB czy DCI P3?

ileśtam procentów (najczęściej 99% pokrycia) AdobeRGB, DCI-P3, sRGB, czy bogowie koloru wiedzą czego, to jest źle, dno, woodorosty i nic na takim ekranie nie widać. To nieprawda, a raczej marketingowe niedopowiedzenie, o czym traktuje ten artykuł: Czy monitor powinien miec pełny gamut kolorów, pokrycie 100% sRGB, AdobeRGB czy DCI P3?

Wszystkiego więcej, więc ile kolorów finalnie zawiera zdjęcie?

Teoria mówi, że miliony albo i miliardy. Wszak 255x255x255 to już dużo, a 1024x1024x1024 to dużo więcej niż dużo. Pamiętajcie, że monitory jak i programy graficzne mają palety jeszcze szersze, nawet 16 bitowe. Czyli ile to będzie 65535x65535x65535? To jest obróbka na palecie: 242141662159875 odcieni. Ponad 240 bilionów odciei! Fajnie, nie?

Rzeczywistość jest jednak "nieco" inna.

Przestrzenie i kolory w praktyce

Wywołanie z RAW-a

Jak wiecie, materiał zgrany z karty aparatu jako RAW, NEF, ARW, CR2 czy jak tam firmy nazywają, to nie jest zdjęcie. To zczytane dane z przetwornika, który po pierwsze nie bardzo jest RGB, oraz niespecjalnie rejestruje kolor, a tylko ilość światła jakie pada na poszczególne elementy fotoczułe, umieszczone za filtrami. Jest to więc materiał zawierający poziomy szarości w dziwacznych proporcjach, wcale nie po równo na kanały RGB.

Konieczne jest więc "wywołanie" RAW-a, czyli użycie oprogramowania, które "wie" jaka jest struktura danych w pliku RAW i przeliczy to na wartości kolorymetryczne każdego piksela zdjęcia. Mówiąc prościej, stworzy plik graficzny.

Gdzie moje miliony, czyli trudne decyzje życiowe fotografa

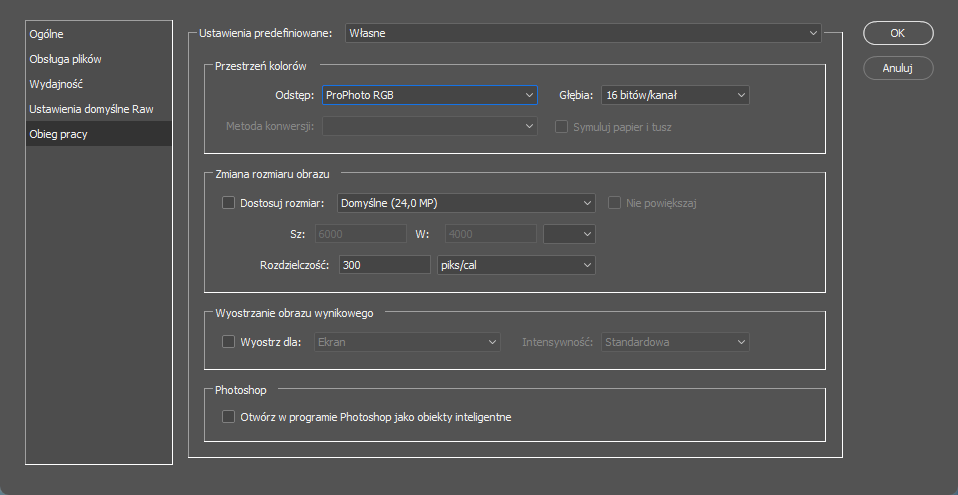

Podczas wywoływania RAW-ów, rzadko kiedy ingeruje się w ustawienia wywołania. A tymczasem na dole, przykład z popularnego Adobe Camera Raw, mamy takie maleńkie coś:

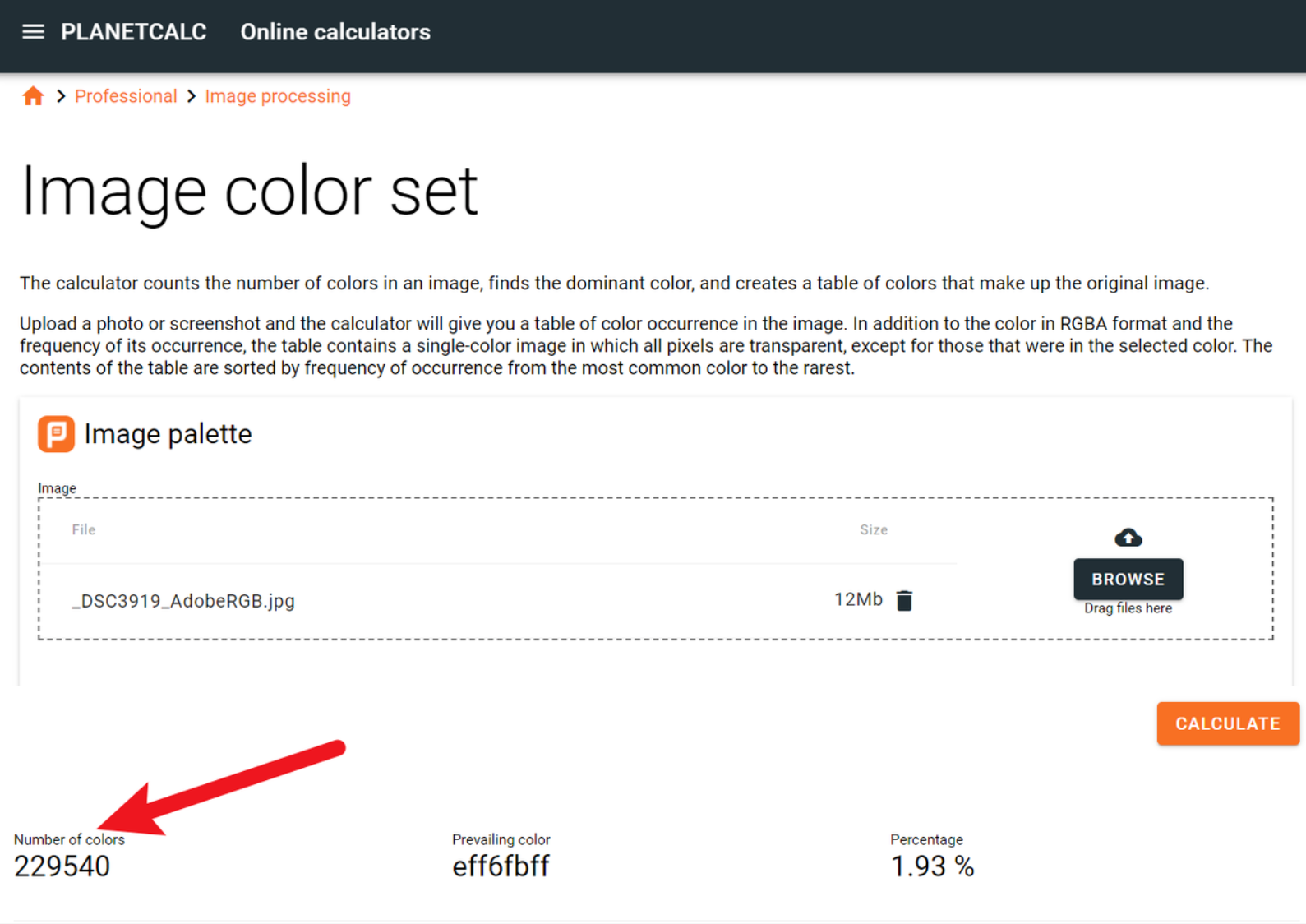

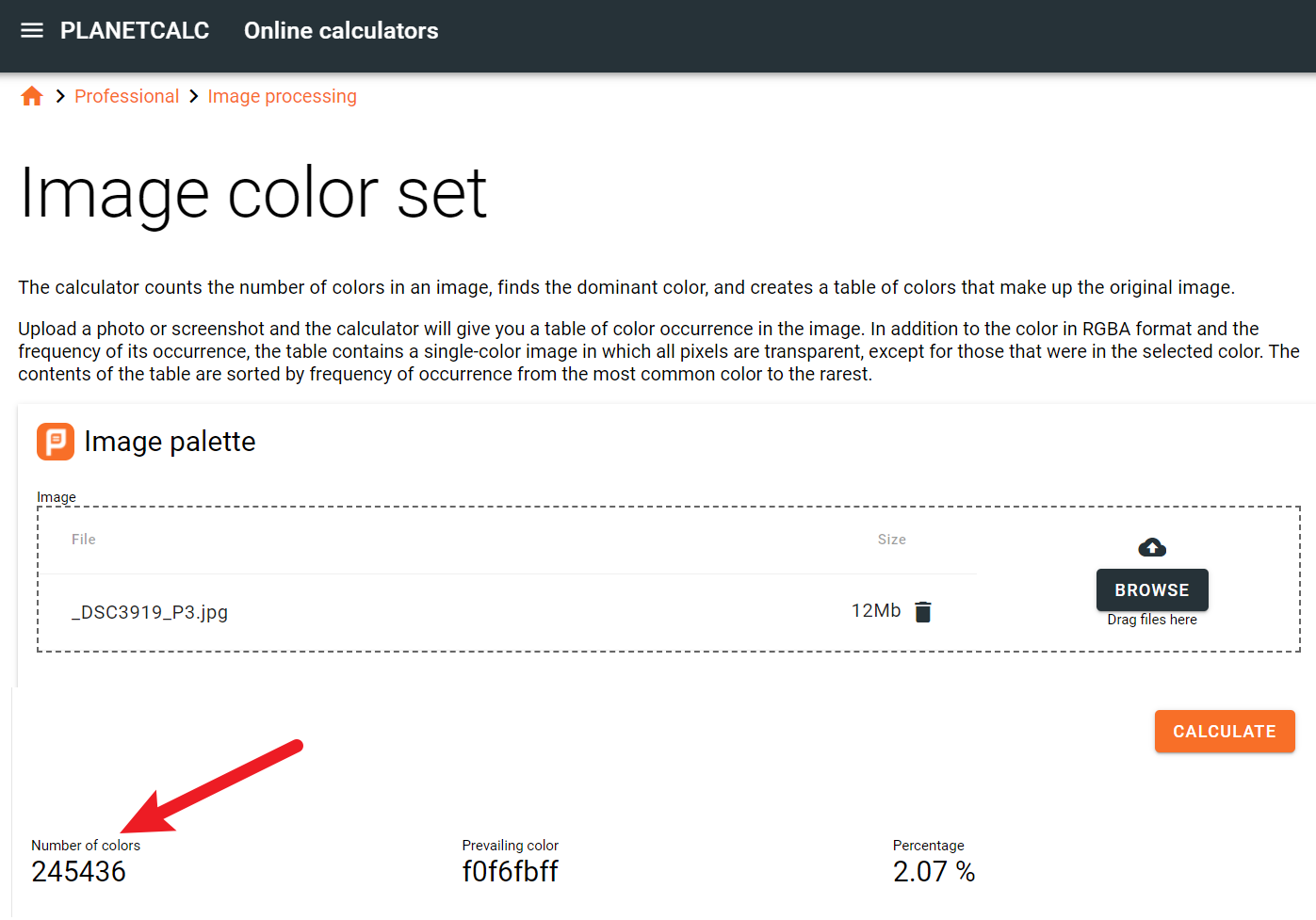

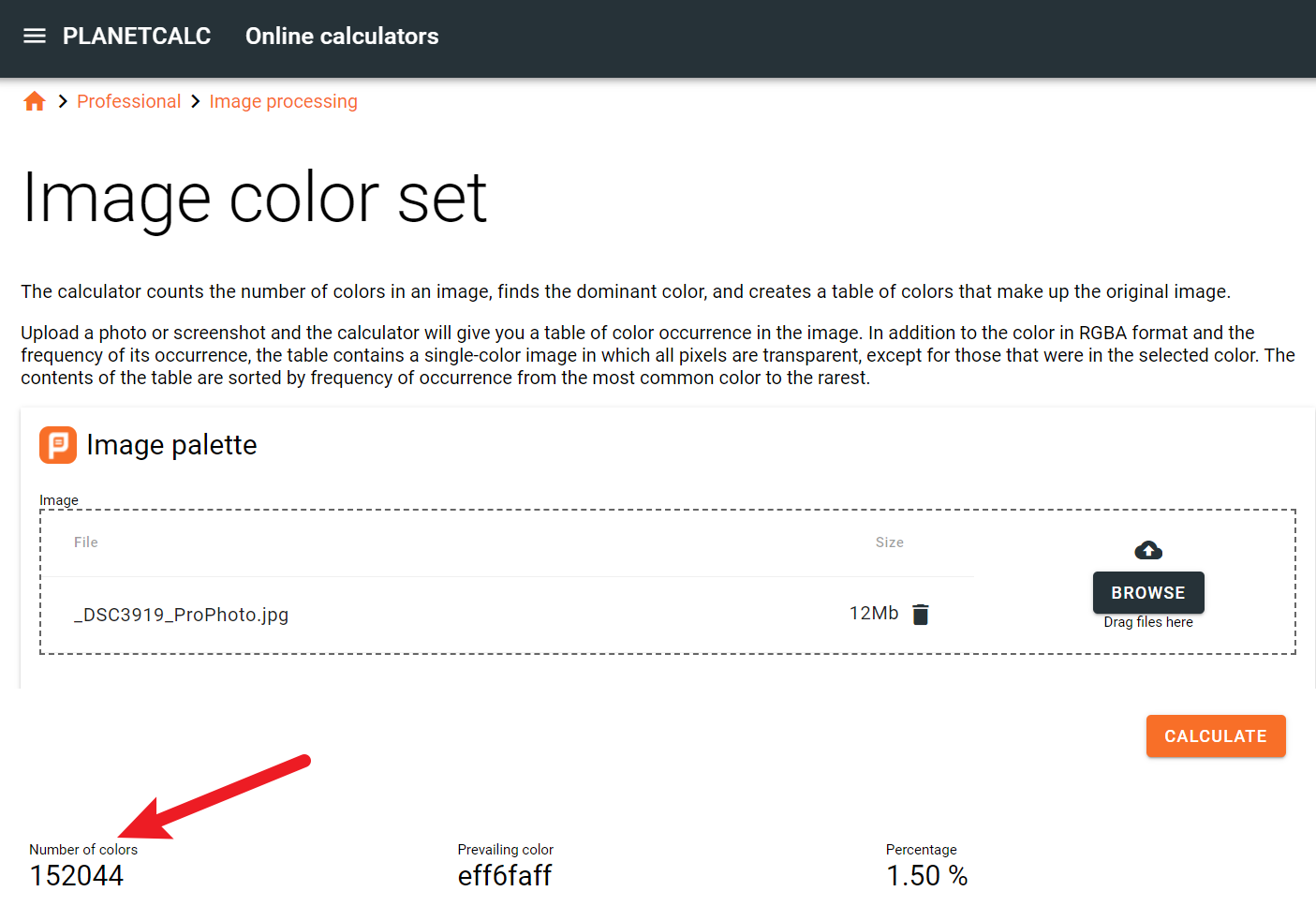

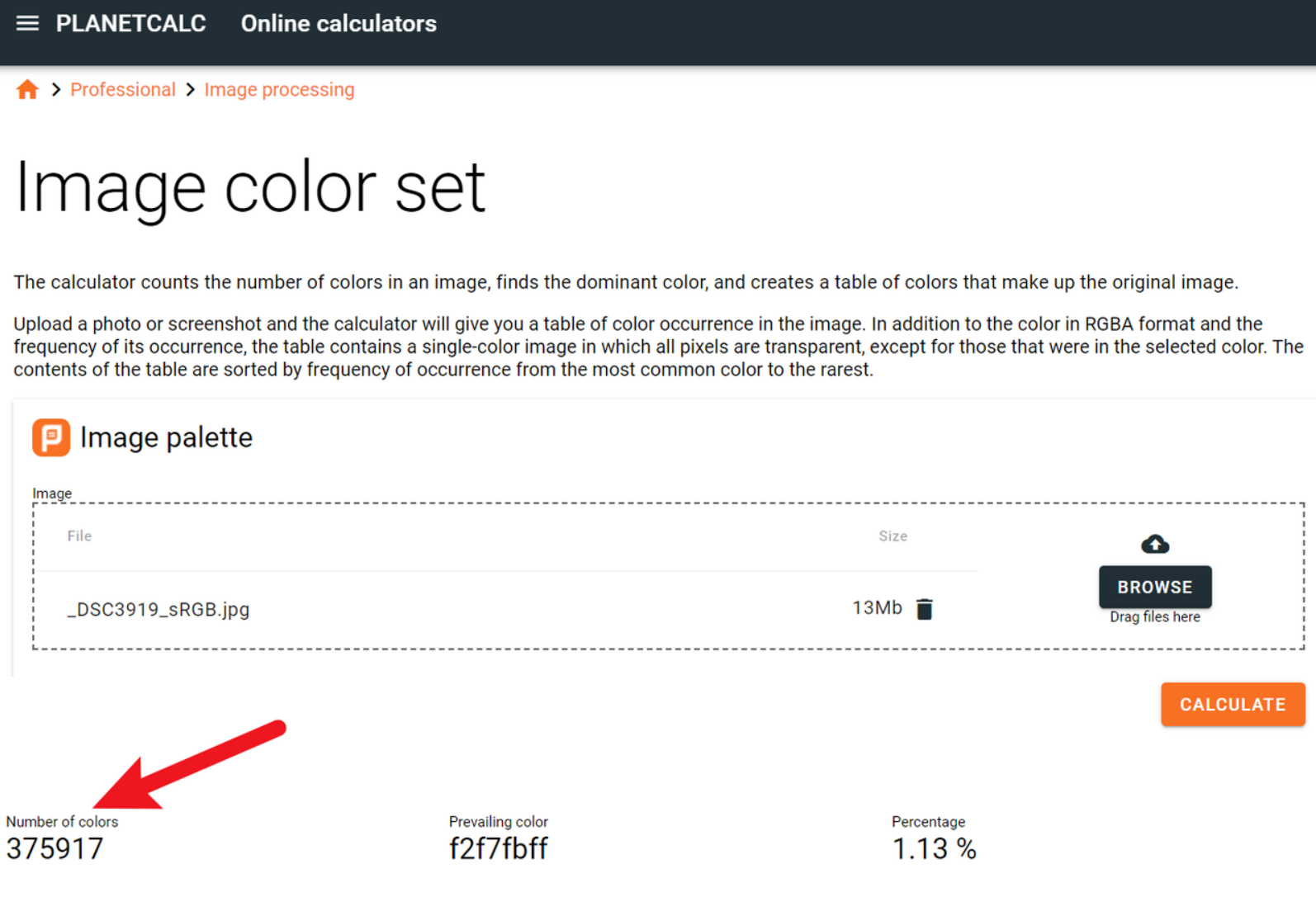

Stoi jak byk Adobe RGB i do takiej przestrzeni będzie renderowane gotowe zdjęcie. Wydaje się dobrze, szersza przestrzeń, więcej kolorów, zdjęcie będzie ze wszech miar lepsze. No, ale jedziemy dalej. Wywołumeny fotę, zapisujemy, oczywiście jako szerokogamutowe i w poczuciu dobrze spełnionego obowiązku idziemy na piw... eee... znaczy... herbatę. Dla porządku i poprawności metodologicznej wrzucam zdjęcie do analizatora. Jest tego dużo, zarówno jako samodzielne aplikacje jak i internetowe, nawet darmowe. No więc wkopiowuję fotkę i widzę: O żesz! Niecałe 300 tys odcieni? Jakiś żart? Gdzie moje miliony i miliardy kolorów? Wywołanie było z rozdzielczością 16 bitową, widać na poprzednim obrazku, czyli powinno być metrowa liczba odcieni, a nie ma! Co do groma? Spróbujmy może do aktualnie najnowszej mody DCI-P3.

O żesz! Niecałe 300 tys odcieni? Jakiś żart? Gdzie moje miliony i miliardy kolorów? Wywołanie było z rozdzielczością 16 bitową, widać na poprzednim obrazku, czyli powinno być metrowa liczba odcieni, a nie ma! Co do groma? Spróbujmy może do aktualnie najnowszej mody DCI-P3.

Jakby lepiej, ale i tak jest kosmiczna różnica między obietnicami we wszelkich poradnikach, artykułach, grupach dyskusyjnych i nawet na wszechwiedzącym Facebooku. Nie tak miało być! Światełko w głowie. Przecież w Lightroomie przestrzenią edycyjną jest Pro Photo. Największa, najlepsza i w ogóle super, debeściarska. Dajemy z grubej rury. Wywołuję do Pro photo!

Wrzucam plik do analizatora, sekundy wczytywania ciągną się w nieskończoność. Cała moja dotychczasowa kolorymetryczna rzeczywistość wisi na włosku nad odchłanią chaosu. Co prawda niby wszystko dąży do entropii, ale bez jaj. No i:

Rozumiecie coś tego?

Rozumiecie coś tego?

Prosta kolorymetria a wygląda jak bałagan

Dlaczego w zdjęciu jest tak mało odcieni?

Sprawa jest trywialna. Otóż zdjęcie to nie jest wzornik ze wszystkimi możliwymi kombinacjami 256 odcieni czerwonego, razy 256 odcieni zielonego, razy 256 odcieni niebieskiego. Nie mówiąc o zapisie 10 bitowym, czyli 1024 na każdy z kanałów. Fotografie różnych rzeczy będą zawierały różną ilość odcieni. Przykładowo, zdjęcie idealnie równej białej ściany będzie zawierało (w przybliżeniu) jeden odcień. Bogaty wizualnie pejzaż będzie zawierał sporo więcej. Nawiasem mówiąc użyte w tym teście zdjęcie to właśnie panorama górska.

Dlaczego im szersza przestrzeń, tym mniej kolorów w zdjęciu?

To też jest proste. W prawdziwym życiu bardzo mocno nasyconych walorów barwnych jest mało. Bo gamut oznacza maksymalne nasycenia. Nic więcej. No więc, mocno nasyconych kolorów w zdjęciu jest bardzo mało. Oznacza to, że zajmują one w przestrzeni barwnej głównie środek, im bliżej granic przestrzeni, czyli w stonę wysokich nasyceń, tym odcieni mniej. Jeśli więc zdjęcie renderujemy do coraz szerszej przestrzeni, coraz więcej odcieni jest "zarezerwowanych" dla odcieni o coraz wyższych nasyceniach a ich fizycznie nie ma. Wniosek jaki się nasuwa, to w przestrzeniach węższych jest coraz więcej. I tak jest, wszak z powyższych przykładów, najszersza jest ProPhoto, potem AdobeRGB i najwęższa z nich to DCI-P3. Oznacza to jednocześnie, że w sRGB powinno być najwięcej. I tak właśnie jest:

Ponad dwa razy więcej unikalnych odcieni niż w ProPhoto! Wywaliło to właśnie do góry kołami Wasze dotychczasowe rozumienie obróbki fotografii i operowania przestrzeniami barwnymi? Założę się, że tak. Skąd zatem całkowicie odwrotne przekazy we wszelkich mediach? To trzecia rzecz prosta w niniejszym artykule. Rynek jest rządzony reklamą. Reklama natomiast preferuje proste słowa - klucze, których ludzie nie muszą rozumieć, a tylko identyfikować w osi złe - dobre. Im szersza przestrzeń, tym lepsza, im więcej procent "pokrycia", tym lepiej. Gdyby natomiast napisać, zgodnie z prawdą, że szersza przestrzeń może dawać jakościowo gorsze zdjęcie, więcej procentów wcale nie oznacza lepszej reprodukcji barwnej, wystąpiłaby kolizja słów - kluczy z rozumieniem konsumenta. Mógłby zacząć drążyć. A pytający "dlaczego", to zły klient. Trzeba mu wytłumaczyć, a wówczas wyszłoby na jaw, że powszechnie operuje się manipulacją. I tym optymistycznym akcentem.... :)

Masz pytanie, wątpliwości albo sugestie do tego artykułu? Wyślij wiadomość

NEC EA271Q COLOR ma przestrzeń odrobinę większą niż sRGB. Proponuję przy tym zapoznać się z artykułem szczegółowo wyjaśniającym sens tego parametru: https://monitory.mastiff.pl/faq/question/id/345 oraz: https://monitory.mastiff.pl/faq/question/id/383